问题随着机器学习对模型运算速度的需求越来越强烈,一直想进行GPU编程,但一直以来这些都是c++的专利一想到c++里的各种坑,就提不起劲来,毕竟这样来来回回填坑的投入产出,生产效率就会大打折扣解决方案让人欣喜的...

”gpu“ 的搜索结果

NVIDIA AMPERE GPU架构深度解析 文章目录NVIDIA AMPERE GPU架构深度解析1. NVIDIA A100 Highlights1.1 NVIDIA A100对比Volta有20x性能的性能提升。1.2 NVIDIA A100的5个新特性1.3 AI加速:使用BERT-LARGE进行训练、...

GPU,也即图形处理单元。不论在手机中,还是在电脑、笔记本上,GPU都发挥着不可替代的作用。往期文章中,小编对 加速原理、GPU服务器选择、GPU存储性能提升等均有所介绍。为增进大家对GPU的认识,本文将对GPU的5种...

这里可以看到GPU和TPU的使用时长,kaggle上能够免费使用的GPU是30小时,TPU是20小时。一般来说,都是用不完的。在Accelerator里面就可以找到GPU了。验证完手机号码,就可以使用GPU了。科学上网一下,才能够看到隐藏...

训练一个卷积模型,gpu训练耗时很久,看了下GPU利用率不高,但是专用GPU内存拉满了,共享GPU是闲置的,既然打游戏GPU内存爆了可以利用共享GPU内存,求问为什么,怎么才能占满资源。而且我的双路3080也没用上.只用了...

GPU 硬件加速是指应用 GPU 的图形性能对浏览器中的一些图形操作交给 GPU 来完成,因为 GPU 是专门为处理图形而设计,所以它在速度和能耗上更有效率 GPU 加速通常包括以下几个部分:Canvas2D,布局合成(Layout ...

Tensorflow有cpu和gpu之分,一般你的电脑上要是有GPU(也就是显卡)推荐安装GPU版本的,这样相对于cpu版本而已,运行速度更快!本次教程主要是GPU版本,需要提前下载对应的cuda和cudnn。安装前的必要工作!!!一定...

特别是 OpenCL 为应用程序提供了对 GPU 的访问,在计算机视觉中,许多算法可以在 GPU 上比在 CPU 上更有效地运行:例如 图像处理、矩阵运算、计算摄影、物体检测等。当选择忽略这些#pragma,或者编译器不支持OpenMP...

Linux 测试 Nvidia GPU卡

近日,业内某AI平台研发负责人江州司马在信服云《云集技术学社》系列直播课上进行了《GPU在AI业务中的核心技术与应用》的分享,详细介绍了GPU的发展、GPU的架构以及如何利用GPU优化AI系统。以下是他分享内容摘要,想...

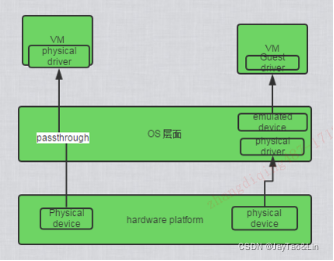

tensorflow会默认将GPU(尽可能的)占满,这样会导致其他程序无法使用GPU,造成GPU内存和计算资源的浪费,通常有以下方法: 设置内存自增长 虚拟设备机制(类似window的磁盘) 多GPU的使用 虚拟GPU和实际GPU ...

pytorch gpu版本安装

1、如果安装paddlepaddle-gpu==2.0.0,然后启动,可能会出现如下问题 python3.6 tools/infer/predict_system.py --image_dir "big.png" --det_model_dir "inference/ch_ppocr_server_v2.0_det_infer" --rec_model_...

1gpu信息获取 1.1 高通gpu说明 高通设备CPU采用cpufreq框架动态调节频率,相似的GPU这块采用了Linux devfreq框架进行调节。Devfreq有四种对频率的管理策略governor(框架规定,实际...

首先捋清楚流程,TensorFlow-GPU和Keras-GPU安装需要和显卡、cuda、cudnn的版本一一对应,如果一开始就用pip命令下载非常容易出错。参考1、查看显卡:终端输入nvidia-smi -q | grep Product2、确定NVIDIA显卡的计算...

一、ubuntu 查看GPU的版本信息和使用情况 1.1 使用nvidia自带的nvidia-smi的命令行工具 1.1.1 查看静态使用情况(当前GPU使用情况) nvidia自带了一个nvidia-smi的命令行工具,会显示显存的使用情况 nvidia-smi ...

GPU加速技术&原理介绍 1、GPU&CPU GPU英文全称Graphic Processing Unit,中文翻译为“图形处理器”。与CPU不同,GPU是专门为处理图形任务而产生的芯片。从这个任务定位上面来说,不仅仅在计算机的...

在使用服务器跑代码的时候,我们暂停代码,但是GPU缺占用着使用,怎么解决呢?1.我们可以用如下命令查看 nvidia-smi看不到的GPU进程。发现内存泄露问题,即没有进程时,内存被占用。最后就又能重新跑代码了呀。发现...

使用两种方法,实时查看 GPU 使用情况 1. nvidia-smi 使用终端命令 nvidia-smi 查看显卡信息 如果你想实时检测显卡使用情况,添加 watch -n 即可 watch -n 4 nvidia-smi 其中,4 是指 4 秒刷新一次终端,可以根据...

运行python文件时,在前面加上 CUDA_VISIBLE_DEVICES=xxx,xxx是你要指定的gpu序号。如`CUDA_VISIBLE_DEVICES=0,2 python extract_masks.py`表示指定了0、2号两个gpu。注意,序号是从0开始排的,所以如果你只有一个...

推荐文章

- Android RIL框架分析-程序员宅基地

- Python编程基础:第六节 math包的基础使用Math Functions_ps math function-程序员宅基地

- canal异常 Could not find first log file name in binary log index file_canal could not find first log file name in binary-程序员宅基地

- 【练习】生成10个1到20之间的不重复的随机数并降序输出-程序员宅基地

- linux系统扩展名大全,Linux系统文件扩展名学习-程序员宅基地

- WPF TabControl 滚动选项卡_wpf 使用tabcontrol如何给切换的页面增加滚动条-程序员宅基地

- Apache Jmeter常用插件下载及安装及软硬件性能指标_jmeter插件下载-程序员宅基地

- SpringBoot 2.X整合Mybatis_springboot2.1.5整合mybatis不需要配置mapper-locations-程序员宅基地

- ios刷android8.0,颤抖吧 iOS, Android 8.0正式发布!-程序员宅基地

- 【halcon】C# halcon 内存暴增_halcon 读二维码占内存-程序员宅基地