本文档详细介绍了搭建SPARK源码阅读环境的步骤及方法。SPARK源码的阅读有助于了解SPARK运行的内部机制,便于优化,对有志于大数据学习及科研的人员都是很重要的。

”spark环境搭建“ 的搜索结果

注意: yarn 是作为资源管理器存在,每次提交一个任务时, spark 会做两件事,一个是将代码分成多个 stage ,每个 stage 相当于一个计算,然后再把 stage 分成多个 task ,每个 task 执行相同的操作,只不过操作的...

1、前提是Hadoop环境已经搭建完成,ssh当然也已经配置完成,官网下载软件包: scala-2.11.0.tgz spark-2.1.0-bin-hadoop2.6.tgz 使用了两台虚拟机master 和slave01,其中master是Hadoop的namenode节点所在,...

参考博文:Hadoop+HBase+Spark+Hive环境搭建

百度经验:http://jingyan.baidu.com/article/7e440953308f122fc0e2ef81.html Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS: http://www.powerxing.com/install-hadoop-cluster/

Apache Spark开发环境搭建

Spark是一个快速、通用、可扩展的大数据处理引擎,最初由加州大学伯克利分校的AMPLab开发。Spark提供了一种基于内存的分布式计算模型,能够在大规模数据集上进行高效的数据处理、机器学习和图形计算等任务。Spark...

spark搭建手册

主要介绍了PyCharm搭建Spark开发环境的实现步骤,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧

前言:本人水平有限,目前在前辈的指导下进行Spark开发的自学...Spark开发环境搭建 一、Java环境搭建 安装java环境需要安装部署JDK和JRE,本次选择的JDK版本是1.8。前往官网即可下载,官网链接:JDK下载地址。 我们...

hadoop + spark 环境搭建以及演示scala + spark + maven 项目集成 打包 向spark 平台submit任务 spark-history-server 配置 和 查看 spark 历史任务执行记录

Spark在做数据的批处理计算,计算性能大约是Hadoop MapReduce的10~100倍,因为Spark使用比较先进的基于 DAG 任务调度,可以将一个任务拆分成若干个阶段,然后将这些阶段分批次交给 集群计算节点 处理。 MapReduce ...

环境介绍:IntelliJ IDEA开发软件,hadoop01-hadoop04的集群(如果不进行spark集群测试可不安装) 准备工作首先在集群中的hdfs中添加a.txt文件,将来需在项目中进行单词统计 构建Maven项目点击File->New->Project…...

hadoop、hive、spark

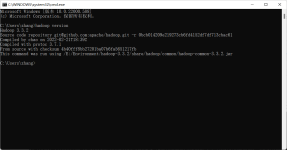

windows下spark环境搭建

spark : http://spark.apache.org/downloads.html hadoop : http://hadoop.apache.org/releases.html jdk: http://www.oracle.com/technetwork/java/javase/downloads/index-jsp-138363.html hado...

该文章是在hadoop环境搭建好的基础上进行的,主要是针对搭建过程中自己遇到的一些小问题。关于hadoop的搭建详见:http://blog.csdn.net/svmachine/article/details/51334188一 环境 hadoop:hadoop2.6.0 spark:...

主要介绍了PyCharm搭建Spark开发环境实现第一个pyspark程序,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧

NULL 博文链接:https://aperise.iteye.com/blog/2302535

推荐文章

- cocos creator 实现截屏截图切割转成 base64分享--facebook小游戏截图base64分享,微信小游戏截图分享【白玉无冰】每天进步一点点_cocos上传base64-程序员宅基地

- Docker_error running 'docker: compose deployment': server-程序员宅基地

- ChannelSftp下载目录下所有或指定文件、ChannelSftp获取某目录下所有文件名称、InputStream转File_channelsftp.lsentry获取文件全路径-程序员宅基地

- Hbase ERROR: Can‘t get master address from ZooKeeper; znode data == null 解决方案_error: can't get master address from zookeeper; zn-程序员宅基地

- KMP的最小循环节_kmp求最小循环节-程序员宅基地

- 详解ROI-Pooling与ROI-Align_roi pooling和roi align-程序员宅基地

- Imx6ull开发板Linux常用查看系统信息指令_armv7 processor rev 2 (v7l)-程序员宅基地

- java SSH面试资料-程序员宅基地

- ant design vue table 高度自适应_对比1万2千个Vue.js开源项目发现最实用的 TOP45!火速拿来用!...-程序员宅基地

- 程序员需要知道的缩写和专业名词-程序员宅基地