”优化器“ 的搜索结果

在深度学习中,优化器(optimizer)是一种用于调整神经网络模型参数以最小化损失函数的算法。优化器的目标是根据输入数据和期望的输出标签来调整模型的权重和偏置,使得模型能够更好地拟合训练数据并在未见过的数据...

在PyTorch中,优化器(Optimizer)是用于更新神经网络参数的工具。它根据计算得到的损失函数的梯度来调整模型的参数,以最小化损失函数并改善模型的性能。即优化器是一种特定的机器学习算法,通常用于在训练深度学习...

barra优化器用户手册,这个权威的官方文档,各位搞资产组合优化的伙伴可以参考该文档做组合优化,风险控制。

GUROBI OPTIMIZER REFERENCE MANUAL

在深度学习中,优化器是一个非常重要的组成部分,它通过调整模型参数的方式来最小化损失函数。本教程将介绍三种常用的优化器以及如何选择最合适的优化器。

优化器(Optimizer)是深度学习中一个核心的概念,用于更新神经网络的权重,以减少或最小化损失函数(loss function)的值。损失函数衡量了模型的预测值与真实值之间的差异,而优化器的目标是通过调整网络参数来最小...

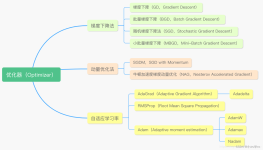

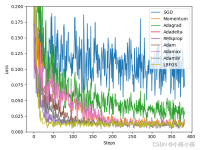

优化器总结 机器学习中,有很多优化方法来试图寻找模型的最优解。比如神经网络中可以采取最基本的梯度下降法。 梯度下降法(Gradient Descent) 梯度下降法是最基本的一类优化器,目前主要分为三种梯度下降法:...

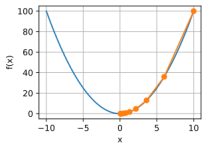

(1)解释一言以蔽之,优化器就是在深度学习反向传播过程中,指引损失函数(目标函数)的各个参数往正确的方向更新合适的大小,使得更新后的各个参数让损失函数(目标函数)值不断逼近全局最小。(2)原理解释优化...

目前有两种主流优化器:随机梯度下降系(Stochastic Gradient Descent, SGD)和Adam系。应该认识到的是,优化器并不是某类数学上的优化算法,而是梯度下降(一阶迭代法)的工程实现方案和包装。

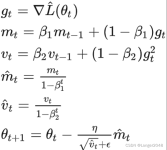

文章详细介绍了优化器在深度学习中的作用,按照出现时间的顺序依次介绍各种优化器的实现原理附带个人理解的通俗数学公式,而且有torch中封装好的函数类用法和参数介绍等等,也包括优化器各自的优缺点,以及常用超...

优化器是深度学习中用于优化神经网络模型的一类算法,其主要作用是根据模型的损失函数来调整模型的参数,使得模型能够更好地拟合训练数据,提高模型的性能和泛化能力。优化器在训练过程中通过不断更新模型的参数,使...

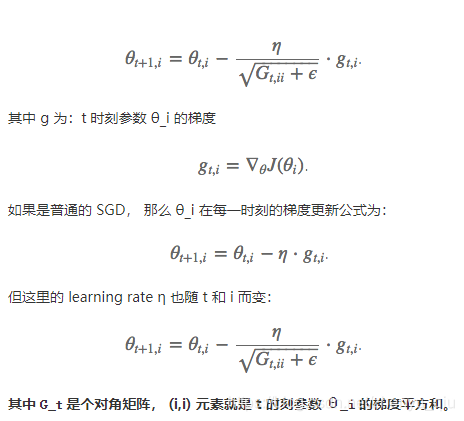

这是一个系列,以Pytorch为例,介绍所有主流的优化器,如果都搞明白了,对优化器算法的掌握也就差不多了。作为系列的第一篇文章,本文介绍Pytorch中的SGD、ASGD、Rprop、Adagrad,其中主要介绍SGD和Adagrad。因为这...

AdamW

在PyTorch中,优化器(Optimizer)是用于`更新神经网络参数的工具`。它`根据计算得到的损失函数的梯度来调整模型的参数`,以`最小化损失函数并改善模型的性能`。 即优化器是一种特定的`机器学习算法`,通常用于在...

谷歌 Lion 优化器添加教程

MySQL 优化器

在之前的文章了,我们学习了SGD,以及在其基础上加了一阶动量的SGD Momentum,还有在其基础上加了二阶动量的AdaGrad、AdaDelta...那么自然而然就会想到把一阶动量和二阶动量结合起来,这样就形成了我们常用的优化器Adam

很多情况下,我们调用优化器的时候都不清楚里面的原理和构造,主要基于自己数据集和模型的特点,然后再根据别人的经验来选择或者尝试优化器。下面分别对SGD的原理、pytorch代码进行介绍和解析。

优化器的作用: 用来更新和计算影响模型训练和模型输出的网络参数,使其逼近或达到最优值,从而最小化(或最大化)损失函数。 在深度学习中,几乎所有流行的优化器都基于梯度下降。这意味着他们反复估计给定的损失函数...

推荐文章

- Springboot——mybatis配置_springboot配置mybatis-程序员宅基地

- 计算机网络体系结构-程序员宅基地

- 韶音、南卡、Oladance开放式耳机值得买吗?多维度测评实力最强品牌-程序员宅基地

- bert简介_tensorflow 2.0+ 基于BERT的多标签文本分类-程序员宅基地

- jupyter notebook常用快捷键和语法_jupyter notebook怎么换行-程序员宅基地

- 教材编者,请多点儿“钻研”精神-程序员宅基地

- MySQL如何更改数据库名字_mysql update数据库名称-程序员宅基地

- windows上最好用的文件管理软件 Directory Opus_directory ops-程序员宅基地

- AWT图形界面设计编程——1.AWT容器_awt容器定义-程序员宅基地

- 一文看懂mybatis底层运行原理解析-程序员宅基地