”学习率“ 的搜索结果

主要介绍了pytorch实现查看当前学习率,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧

小白笔记:学习率的概念、本质及其更新策略

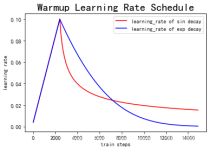

较高的学习率可能会导致模型跳过全局最优解并陷入局部最优解,而较低的学习率可能需要更多的迭代才能达到全局最优解。收敛速度:较高的学习率可以加快模型的收敛速度,因为参数更新更大,模型能够更快地找到损失函数...

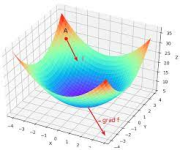

学习率是训练神经网络的重要超参数之一,它代表在每一次迭代中梯度向损失函数最优解移动的步长,通常用 η 表示。它的大小决定网络学习速度的快慢。在网络训练过程中,模型通过样本数据给出预测值,计算代价函数并...

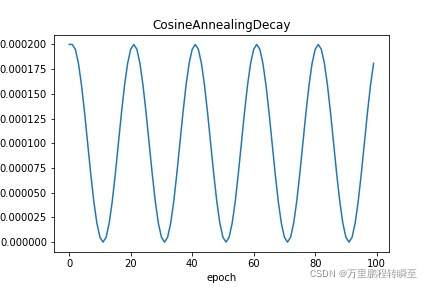

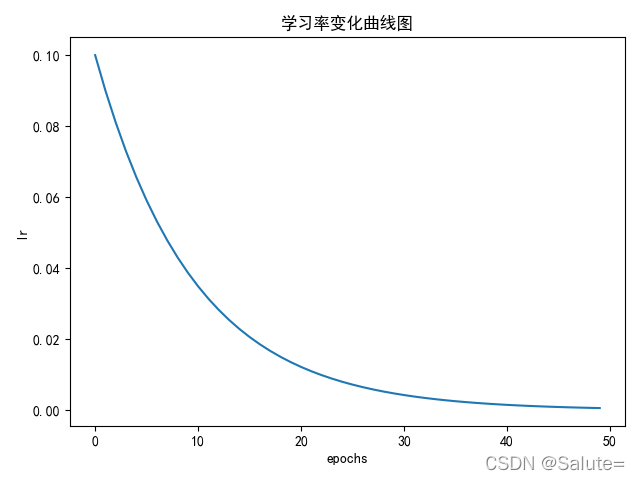

keras学习率余弦退火CosineAnnealing1.引言2.余弦退火的原理3.keras实现 1.引言 当我们使用梯度下降算法来优化目标函数的时候,当越来越接近Loss值的全局最小值时,学习率应该变得更小来使得模型不会超调且尽可能...

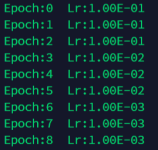

学习率-pytorch

标签: pytorch

对于刚刚接触深度学习的的童鞋来说,对学习率只有一个很基础的认知,当学习率过大的时候会导致模型难以收敛,过小的时候会收敛速度过慢,但其实学习率是一个十分重要的参数,合理的学习率才能让模型收敛到最小点而非...

本文全面深入地探讨了机器学习和深度学习中的学习率概念,以及其在模型训练和优化中的关键作用。文章从学习率的基础理论出发,详细介绍了多种高级调整策略,并通过Python和PyTorch代码示例提供了实战经验。

我的需求:我需要在yolov7中更改其中一层的学习率,但yolov7的学习率是随着eporch的变化动态变化的。

深度学习:Pytorch最全面学习率调整策略lr_scheduler

pytorch学习率调整方法总结

学习率调度(Learning Rate Scheduling)是在训练深度学习模型时,动态地调整学习率的策略。适当的学习率调度可以帮助模型更快地收敛并获得更好的性能。

将输出误差反向传播给网络参数,以此来拟合样本的输出,本质上是最优化的一个过程,逐步趋向于最优解,但是每一次更新参数利用多少误差,就需要通过一个参数来确定,这个参数就是学习率,也称步长 学习率作为监督...

1. 什么是学习率 调参的第一步是知道这个参数是什么,它的变化对模型有什么影响。 (1)要理解学习率是什么,首先得弄明白神经网络参数更新的机制-梯度下降+反向传播。参考资料:...

学习率 学习率(learning_rate):表示了每次参数更新的幅度大小。 学习率过大:会导致待优化的参数在最小值附近进行波动; 学习率过小:会导致待优化参数收敛的速度慢 参数更新 在训练过程中,参数更新向着损失...

推荐文章

- 小说网站系统源码|PHP付费小说网站源码带app-程序员宅基地

- Swift编码规范_swift 正则判断文件类型-程序员宅基地

- 关于shell 中return用法解释(转)_shell return-程序员宅基地

- Linux编译宏BUILD_BUG_ON_ZERO-程序员宅基地

- c51语言单片机打铃系统设计,基于单片机的自动打铃系统的设计-程序员宅基地

- 在php中使用SMTP通过密抄批量发送邮件-程序员宅基地

- python数据清洗+数据可视化_python课程题目数据清除与可视化-程序员宅基地

- 【11g】3.3 Oracle自动存储管理存储配置_oraclestorageoptions-程序员宅基地

- signature=b2f9171fa2897cefe08a669efaf58433,FULFILLMENT TRACKING IN ASSET-DRIVEN WORKFLOW MODELING-程序员宅基地

- 宜兴市计算机中等学校,重磅!江苏省陶都中等专业学校正式揭牌!-程序员宅基地