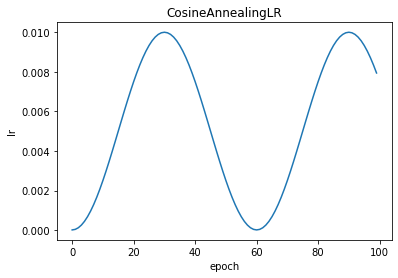

CosineAnnealingLR是余弦退火学习率,T_max是周期的一半,最大学习率在optimizer中指定,最小学习率为eta_min。这里同样能够帮助逃离鞍点。值得注意的是最大学习率不宜太大,否则loss可能出现和学习率相似周期的上下...

”学习率lr“ 的搜索结果

在模型训练过程中,学习率是一个非常敏感且重要的参数,在神经网络的反向传播算法中,梯度下降是一种常用的参数求解方法,学习率影响着梯度下降过程中参数更新的步长。通常,神经网络的参数空间很大,梯度下降的求解...

Environment OS: macOS Mojave Python version: 3.7 PyTorch version: 1.4.0 IDE: PyCharm ...PyTorch 在 torch.optim.lr_scheduler 中提供了十种调整学习率的类,它们的基类为 torch.optim.lr_scheduler._LRSc

在pytorch训练过程中可以通过下面这一句代码来打印当前学习率 print(net.optimizer.state_dict()[‘param_groups’][0][‘lr’]) 补充知识:Pytorch:代码实现不同层设置不同的学习率,选择性学习某些层参数 1,...

持inverse square root scheduler,按总epoch的4%或6%设置warm up步长,0-warmup_steps期间lr线性增长(从0到设置的lr),随后指数衰减。第3组:inverse square root scheduler with linear warmup(与第1组一样), ...

Pytorch学习率调整策略通过 torch.optim.lr_sheduler 接口实现。pytorch提供的学习率调整策略分为三大类,分别是: 有序调整:等间隔调整(Step),多间隔调整(MultiStep),指数衰减(Exponential),余弦退火...

今天在学习动物多分类的代码,需要调参,loss从第二个epoch开始就不在下降了,后来发现是学习率的问题,学习率过大,导致loss难以下降,后来陈助教建议我调小了学习率,果然效果就好多了;于是我复习了一下吴教授...

在一个数据集上训练模型,训练很多个epoch后,学习率lr已经变得很小,需要改变lr 想在新数据集上加载此模型,使用model.load_weights后,模型的学习率仍为原来的小学习率 加入代码 from keras import backend as K #...

深度学习:Pytorch最全面学习率调整策略lr_scheduler

设学习率为 lrlrlr,那么 更新一次梯度后为:x1=x0−lr∗g(x0)=x0−lr∗2x0=(1−2∗lr)x0x_1 = x_0 - lr * g(x_0) = x_0 - lr * 2x_0 = (1 - 2 * lr)x_0x1=x0−lr∗g(x0)=x0−lr∗2x0=(1−2∗lr

在开启学习机器学习之前,我们先来了解了解机器学习中重要的参数吧,本文介绍了机器学习的基础内容之学习率(LR),本文仅仅简单介绍了学习率(LRlearningrate),而LR的调整对于网络模型的性能有重大影响,有很多的...

torch.optim.SGD(net.parameters(), lr=lr, momentum=0.9,weight_decay=wd) 第一个参数包括权重w,和...第二个参数lr是学习率 第三个参数momentum是冲量 第四个参数weight_decay是权重衰减 另外可点击参考此链接 ...

1. 什么是学习率 调参的第一步是知道这个参数是什么,它的变化对模型有什么影响。 (1)要理解学习率是什么,首先得弄明白神经网络参数更新的机制-梯度下降+反向传播。参考资料:...

torch.optim.lr_scheduler 提供了一些基于 epoch 调整学习率的方法,基本使用方法如下: optimizer = torch.optim.SGD(model.parameters(), lr=1e-2, momentum=0.9, weight_decay=1e-5) scheduler = torch.optim....

2.1、初始学习率大小对模型性能的影响2.2、学习率变换策略对模型性能的影响2.2.1 预设规则学习率变化法2.2.2 自适应学习率变化法2.3、小结3 Batchsize如何影响模型性能?3.1、大的batchsize减少训练时间,提高稳定性...

推荐文章

- [LINUX]sed查找不包含某个字符串的行,并进行替换_sed不包含字符串-程序员宅基地

- 问题解决:shared_ptr Assertion px != 0 failed 及debug经验分享_typename boost::detail::sp_dereference<t>::type bo-程序员宅基地

- 看不见的“网” ,一文读懂阿里云基础设施网络_阿里云网络基线理解-程序员宅基地

- TCP/UDP常见端口参考_怎么查看端口映射的是tcp还是udp-程序员宅基地

- 优化微信小程序音频播放,实现多音频同时播放,互不干扰。_微信小游戏 inneraudiocontext 数量限制-程序员宅基地

- android JSBridge 漏洞挖掘_adnroid jsbridge 不安全的资源引用-程序员宅基地

- OpenCV+Mediapipe+UDP+Unity挥手电子书翻页_unity opencv 虚拟翻书-程序员宅基地

- 【vue运行项目报错】vue前端项目,安装依赖报错,运行不成功解决方案_前端项目运行不了-程序员宅基地

- Linux 文件系统 EXT4 的前世今生-程序员宅基地

- 别人家的公司:微软为员工发1500美元疫情奖金-程序员宅基地