”梯度消失“ 的搜索结果

梯度消失和梯度爆炸的原因和解决办法

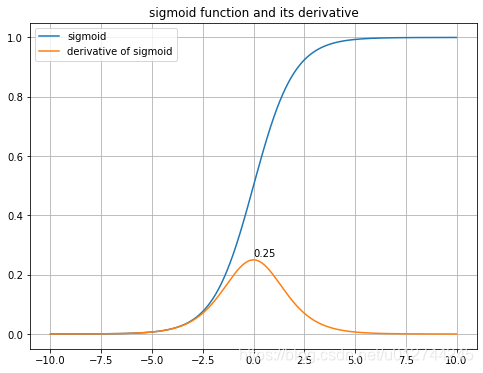

梯度消失问题的解决方法 梯度消失问题 Sigmoid函数 梯度范围可能变得越来越小 在反向传播超过5层后,梯度可能会消失 激活函数 ReLU函数(rectified linear unit) 导数: ReLU可被近似为softplut函数 x增加时...

梯度消失解释及简单举例

标签: 机器学习

梯度消失

什么是梯度消失与梯度爆炸 层数比较多的神经网络模型在使用梯度下降法对误差进行反向传播时会出现梯度消失和梯度爆炸问题。梯度消失问题和梯度爆炸问题一般会随着网络层数的增加变得越来越明显。 例如,对于图所示...

使用残差连接(Residual Connections):例如,在ResNet架构中使用的残差连接允许一部分梯度直接流过网络,从而减少梯度消失的影响。使用ReLU激活函数:ReLU(Rectified Linear Unit)函数在正数区间的导数是常数,...

1.背景介绍 深度学习是一种人工智能技术,它...然而,在深度学习网络中,由于权重的累积,梯度会逐渐趋于零,导致梯度消失(vanishing gradient)问题。梯度消失问题会导致模型训练过慢或无法收敛。为了解决这个问题...

1 、什么是梯度消失和梯度爆炸 在反向传播过程中需要对激活函数进行求导,如果导数大于1,那么随着网络层数的增加梯度更新将会朝着指数爆炸的方式增加这就是梯度爆炸。同样如果导数小于1,那么随着网络层数的增加...

梯度消失及梯度爆炸 循环神经网络进阶 GRU LSTM 深度神经网络 过拟合、欠拟合及其解决方案 训练误差和泛化误差 在解释上述现象之前,我们需要区分训练误差(training error)和泛化误差(generalization error)。...

3, 梯度消失和爆炸的定义 4,梯度消失和爆炸的解决方法 1,过拟合和欠拟合的定义 无论在机器学习还是深度学习建模当中都可能会遇到两种最常见结果,一种叫过拟合(over-fitting )另外一种叫欠拟合(under-...

Task3过拟合、欠拟合及其解决方案训练误差、泛化误差模型选择验证数据集K折交叉验证过拟合欠拟合概念模型复杂度解决过拟合权重衰减(加上L2范数惩罚项)丢弃法梯度消失、梯度爆炸初始化模型参数Xavier随机初始化协...

最近参加了伯禹平台和Datawhale等举办的《动手学深度学习PyTorch版》课程,对过拟合,欠拟合,梯度消失,梯度爆炸做下笔记。 过拟合和欠拟合 模型无法得到较低的训练误差,我们将这一现象称作欠拟合(underfitting)...

梯度消失、梯度爆炸以及Kaggle房价预测 梯度消失和梯度爆炸 考虑到环境因素的其他问题 Kaggle房价预测

这意味着当网络的输出位于饱和区域时,梯度的变化几乎为零,无法有效地传递和更新梯度,导致梯度消失的问题。这会导致网络无法进行正常的前向传播和反向传播。不稳定的更新:梯度爆炸使得参数的更新量非常大,可能会...

深度神经网络中的爆炸和消失梯度 增加神经网络的深度通常会提高准确性。 但是,随着神经网络中层数的增加,损失函数相对于未知参数(权重和偏差)的梯度可能会爆炸或消失。 相关工作 这是一些最近的论文,探讨了梯度...

过拟合和欠拟合 我们将探究模型训练中经常出现的两类典型问题: 一类是模型无法得到较低的训练误差,我们将这一现象称作欠拟合(underfitting); 另一类是模型的训练误差远小于它在测试数据集上的误差,我们称该...

1. 过拟合、欠拟合及其解决方案 本节主要讲了3个点,1. 过拟合、欠拟合的概念 2. 权重衰减 3. 丢弃法 其中权重衰减只讲了L2正则化,其实还有L1正则化、L12正则化等。 丢弃法其实就是Dropout,只是翻译成了中文。...

GRU和LSTM中的门控设计策略,能够有助于缓解梯度消失或梯度爆炸问题。主要是解决长序列梯度计算中幂指数大小的问题(长序列意味着高阶幂指数计算,容易导致梯度极大或极小),可以通过门控设计来直接减少幂指数大小...

K折交叉验证 由于验证数据集不参与模型训练,当训练数据不够用时,预留大量的验证数据显得太奢侈。一种改善的方法是K折交叉验证(K-fold cross-validation)。在K折交叉验证中,我们把原始训练数据集分割成K个不重合...

神经网络(DNN)其实就是人工神经网络(ANN)的多层实现,一个ANN有2个或者2个以上的隐藏层,则被称为深度神经网络(DNN),下面的内容我们会针对神经网络反向微分过程中产生的梯度爆炸和梯度消失,以及当前有效的缓和方法做...

本文探讨深度学习中经常会提到的概念–梯度消失与梯度爆炸。他们是影响模型收敛,学习好坏的一个重要因素,对此现象也提出了对应的解决方案。在此记录其概念,原因和相关的解决方案,仅供参考。

递归神经网络存在的问题3.1 梯度爆炸与梯度消失是怎么样产生的4. LSTM 1. 简述语言模型 现在的语言模型使用很广泛。最常见的应用之一,就是各种输入法的预测输入。比如,当用户输入一段文字之后,输入法会自动的...

1. 过拟合 欠拟合 特征复杂,但是训练 样本数不足时,会产生过拟合,即训练误差小,但是在测试集上的测试误差比较大,即泛化能力强 解决的办法是增加样本数量 或用L2范数进行征罚。 增加样本数量的方法比较简单,...

推荐文章

- YOLO V8车辆行人识别_yolov8 无法识别路边行人-程序员宅基地

- jpa mysql分页_Spring Boot之JPA分页-程序员宅基地

- win10打印图片中间空白以及选择打印机预览重启_win10更新后打印图片中间空白-程序员宅基地

- 【加密】SHA256加盐加密_sha256随机盐加密-程序员宅基地

- cordys 启动流程_cordys服务重启-程序员宅基地

- net中 DLL、GAC-程序员宅基地

- (一看就会)Visual Studio设置字体大小_visual studio怎么调整字体大小-程序员宅基地

- Linux中如何读写硬盘(或Virtual Disk)上指定物理扇区_dd写入确定扇区-程序员宅基地

- python【力扣LeetCode算法题库】面试题 17.16- 按摩师(DP)_一个有名的讲师,预约一小时为单位,每次预约服务之间要有休息时间,给定一个预约请-程序员宅基地

- 进制的转换技巧_10111100b转换为十进制-程序员宅基地