Kubernetes:从Cloud Provider到Cloud Controller Mananger全解析_uninitialized=true:noschedule-程序员宅基地

技术标签: 云原生 Cloud Controller Manager Cloud Provider Kubernetes

一、背景

1.1 基于Kubernetes的容器云

容器云最主要的功能帮助用户把应用以容器的形式在集群中跑起来。目前很多的容器云平台通过Docker及Kubernetes等技术提供应用运行平台,从而实现运维自动化、快速部署应用、弹性伸缩和动态调整应用环境资源,提高研发运营效率。

1.2 Cloud Provider与云厂商

为了更好的让Kubernetes在公有云平台上运行,提供容器云服务,云厂商需要实现自己的Cloud Provider,即实现cloudprovider.Interface(https://github.com/kubernetes/kubernetes/blob/master/pkg/cloudprovider/cloud.go)。

它是Kubernetes中开放给云厂商的通用接口,便于Kubernetes自动管理和利用云服务商提供的资源,这些资源包括虚拟机资源、负载均衡服务、弹性公网IP、存储服务等。

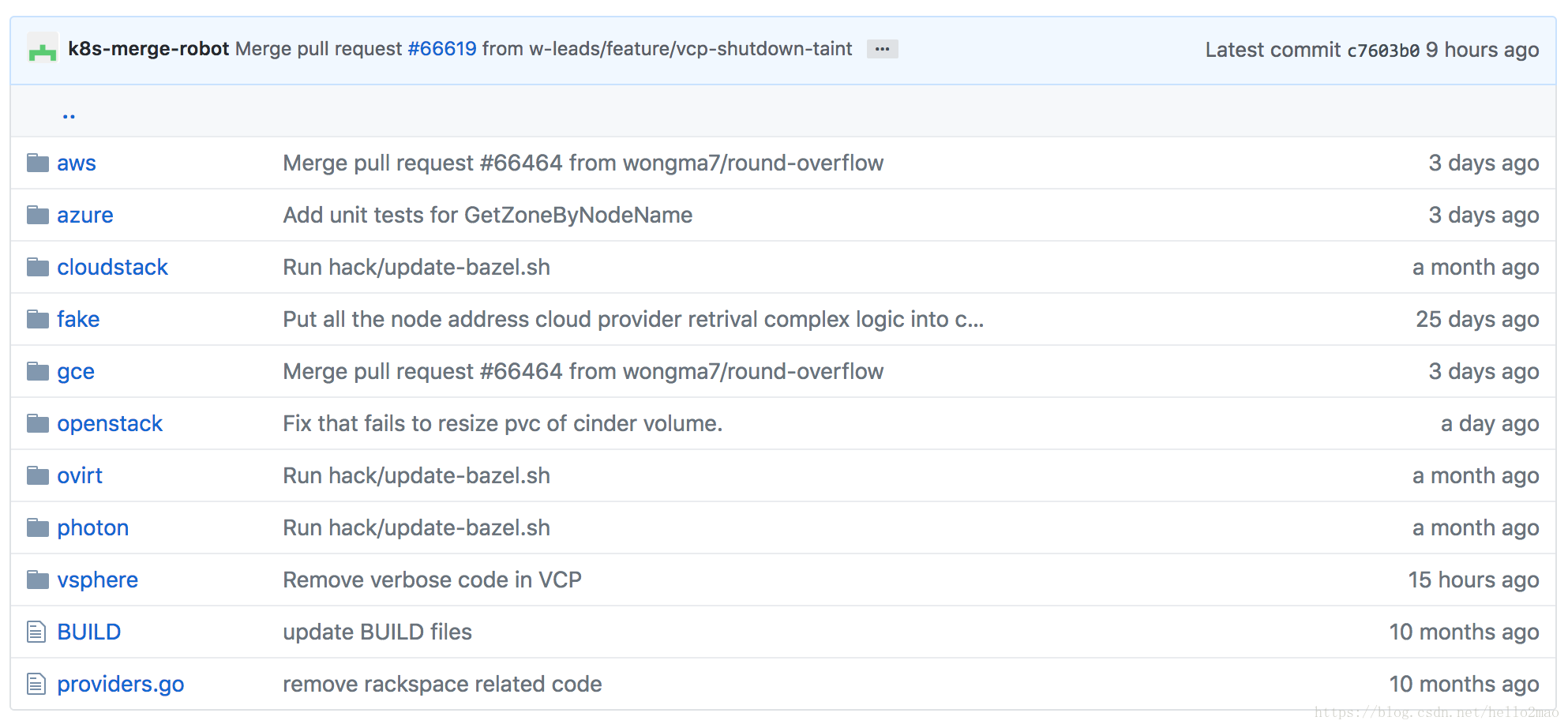

如下图所示,Kubernetes核心库内置了很多主流云厂商的实现,包括aws、gce、azure:

1.3 Cloud Provider的重构之路

但是,问题随之而来。

随着Kubernetes成为在私有云、公有云和混合云环境中大规模部署容器化应用的事实标准,越来越多的云厂商加入了进来,Cloud Provider的实现也越来越多,作为在Kubernetes核心库中的代码,这必将影响其快速的更新和迭代。

所以产生了把Cloud Provider移出Kubernetes核心库并进行重构的提案(Refactor Cloud Provider out of Kubernetes Core)。

在k8s v1.6,引入了Cloud Controller Manager(CCM),目的就是最终替代Cloud Provider。截止到最新的k8s v1.11,还是处于beta阶段。

二、Cloud Provider解析

2.1 Cloud Provider的作用

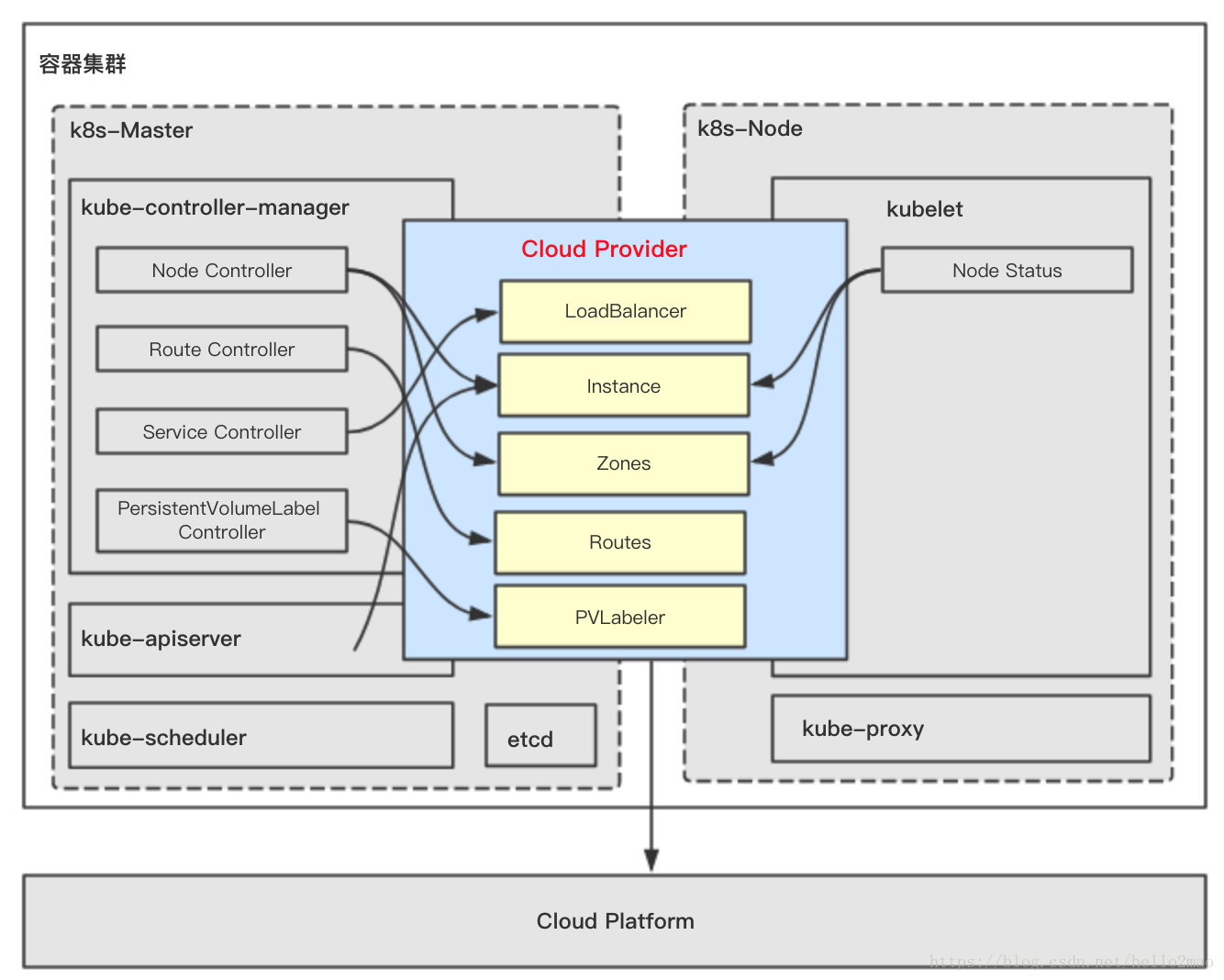

在k8s中有三个组件对Cloud Provider有依赖,分别是:

- kube-controller-manager

- kubelet

- kube-apiserver

这三个组件对Cloud Provider的依赖部分会最终编译进相应的二进制中,进一步的依赖关系如下图所示:

2.1.1 kube-controller-manager依赖Cloud Provider相关部分

kube-controller-manager对Cloud Provider的依赖分布在四个controller中。

2.1.1.1 Node Controller

Node Controller使用Cloud Provider来检查node是否已经在云上被删除了,如果Cloud Provider返回有node被删除了,那么Node Controller立马就会把此node从k8s中删除。

2.1.1.2 Route Controller

用来配置node的路由。

对于Kubernetes的容器网络,基本的原则是:每个pod都拥有一个独立的IP地址(IP per Pod),而且假定所有的pod都在一个可以直接连通的、扁平的网络空间中。而在云上,node的基础设施是由云厂商提供的,所以Route Controller需要调用Cloud Provider来配置云上node的底层路由从而实现Kubernetes的容器网络。

2.1.1.3 Service Controller

Service Controller维护了当前可用node的列表,同时负责创建、删除、更新类型是LoadBalancer的Service,从而使用云厂商额外提供的负载均衡服务、弹性公网IP等服务。

2.1.1.4 PersistentVolumeLabel Controller

PersistentVolumeLabel Controller使用Cloud Provider来创建、删除、挂载、卸载node上的卷,因为卷也是云厂商额外提供的云存储服务。

2.1.2 kubelet依赖Cloud Provider相关部分

kubelet中的Node Status使用Cloud Provider来获得node的信息。包括:

- nodename:运行kubelet的节点名字

- InstanceID, ProviderID, ExternalID, Zone Info:初始化kubelet的时候需要

- 周期性的同步node的IP

2.1.3 kube-apiserver依赖Cloud Provider相关部分

kube-apiserver使用Cloud Provider来给所有node派发SSH Keys。

2.2 Cloud Provider的设计

云厂商在实现自己的Cloud Provider时只需要实现cloudprovider.Interface即可,如下:

type Interface interface {

// 初始化一个k8s client,用于和kube-apiserver通讯

Initialize(clientBuilder controller.ControllerClientBuilder)

// 与负载均衡相关的接口

LoadBalancer() (LoadBalancer, bool)

// 与节点信息相关的接口

Instances() (Instances, bool)

// 与节点可用区相关的接口

Zones() (Zones, bool)

// 与集群相关的接口

Clusters() (Clusters, bool)

// 与路由相关的接口

Routes() (Routes, bool)

// cloud provider ID.

ProviderName() string

// ClusterID

HasClusterID() bool

}重点讲下两个比较重要的接口LoadBalancer()与Routes()。

2.2.1 LoadBalancer()的接口设计

LoadBalancer()接口用来为kube-controller-manager的Service Controller服务,接口说明如下:

type LoadBalancer interface {

// 根据clusterName和service返回是否存LoadBalancer,若存在则返回此LoadBalancer的状态信息,状态信息里包含此LoadBalancer的对外IP和一个可选的HostName

GetLoadBalancer(ctx context.Context, clusterName string, service *v1.Service) (status *v1.LoadBalancerStatus, exists bool, err error)

// 更新或者创建一个LoadBalancer,在用户创建一个type是LoadBalancer的Service时触发。

EnsureLoadBalancer(ctx context.Context, clusterName string, service *v1.Service, nodes []*v1.Node) (*v1.LoadBalancerStatus, error)

// 更新一个LoadBalancer,在Service信息发生改变或者集群信息发生改变时,例如集群新加入一个节点,那么需要更新下LoadBalancer,目的是为LoadBalancer更新下后端需要监听的新节点。

UpdateLoadBalancer(ctx context.Context, clusterName string, service *v1.Service, nodes []*v1.Node) error

// 删除一个LoadBalancer

EnsureLoadBalancerDeleted(ctx context.Context, clusterName string, service *v1.Service) error

}2.2.2 Routes()的接口设计

Routes()接口用来为kube-controller-manager的Route Controller服务,接口说明如下:

type Routes interface {

// 列举集群的路由规则

ListRoutes(ctx context.Context, clusterName string) ([]*Route, error)

// 为当前集群新建路由规则

CreateRoute(ctx context.Context, clusterName string, nameHint string, route *Route) error

// 删除路由规则

DeleteRoute(ctx context.Context, clusterName string, route *Route) error

}三、从Cloud Provider到Cloud Controller Manager

从k8s v1.6开始,k8s的编译产物中多了一个二进制:cloud-controller manager,它就是用来替代Cloud Provider的。

因为原先的Cloud Provider与mater中的组件kube-controller-manager、kube-apiserver以及node中的组件kubelet耦合很紧密,所以这三个组件也需要相应的进行重构。

3.1 kube-controller-manager的重构策略

kube-controller-manager中有四个controller与Cloud Provider相关,相应的重构策略如下:

- Route Controller

- 移入CCM,并在相应的controller loop中运行。

- Service Controller

- 移入CCM,并在相应的controller loop中运行。

- PersistentVolumeLabel Controller

- 移入CCM,并在相应的controller loop中运行。

- Node Controller

- 在CCM中增加新controller:Cloud Node Controller。

- Cloud Node Controller除了实现原来Node Controller的功能外,增加新功能:

- CIDR的管理

- 监控节点的状态

- 节点Pod的驱逐策略

3.2 kube-apiserver的重构策略

对于kube-apiserver使用Cloud Provider的两个功能:

- 分发SSH Keys

- 移入CCM

- 对于PV的Admission Controller

- 在kubelet中实现

3.3 kubelet的重构策略

kubelet需要增加一个新功能:在CCM还未初始化kubelet所在节点时,需标记此节点类似“NotReady”的状态,防止scheduler调度pod到此节点时产生一系列错误。此功能通过给节点加上如下Taints并在CCM初始化后删去此Taints实现:

node.cloudprovider.kubernetes.io/uninitialized=true:NoSchedule四、Cloud Controller Manager解析

4.1 Cloud Controller Manager架构

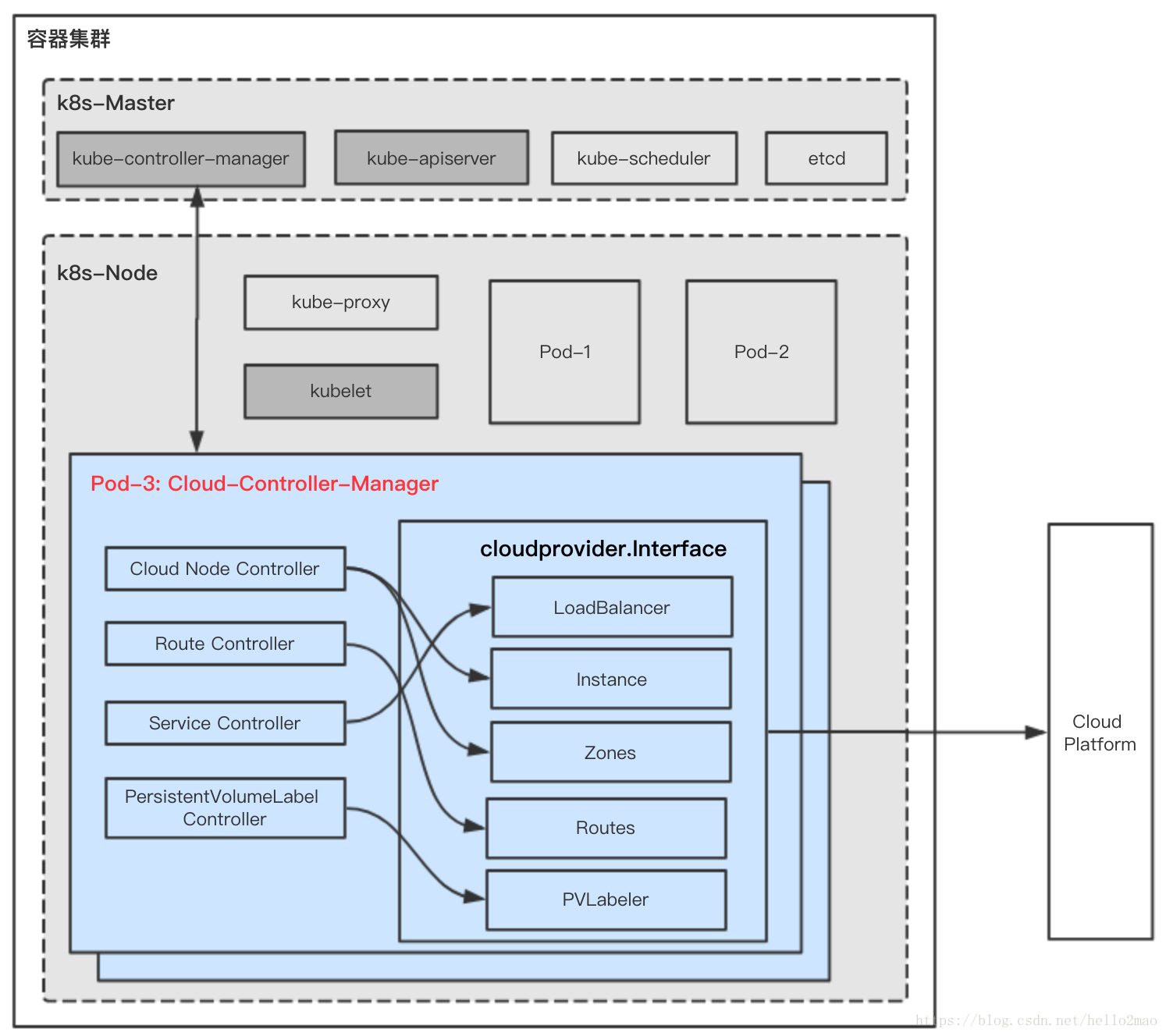

按照第三节所述进行重构后,新的模块Cloud Controller Manager将作为一个新的组件直接部署在集群内,如下图所示:

CCM组件内各小模块的功能与原先Cloud Provider的差不多,见第二节对Cloud Provider的解析。

对于云厂商来说,需要:

(1)实现cloudprovider.Interface接口的功能,这部分在Cloud Provider中已经都实现,直接迁移就行。

(2)实现自己的Cloud Controller Manager,并在部署k8s时,把CCM按要求部署在集群内,部署时的注意事项及部署参考实践见第五节。

4.2 Cloud Controller Manager实现举例

实现自己的CCM也比较简单,举例如下:

package main

import (

...

"k8s.io/kubernetes/cmd/cloud-controller-manager/app"

"k8s.io/kubernetes/cmd/cloud-controller-manager/app/options"

// (1)初始化原来Cloud Provider的相关逻辑,读取cloud配置、初始化云厂商的Clod SDK。

_ "k8s.io/cloud-provider-baiducloud/pkg/cloud-provider"

)

func main() {

goflag.CommandLine.Parse([]string{})

// (2) 初始化一个默认的CCM配置

s, _ := options.NewCloudControllerManagerOptions()

if err != nil {

glog.Fatalf("unable to initialize command options: %v", err)

}

// (3) CCM启动命令

cmd := &cobra.Command{

Use: "cloud-controller-manager",

Long: `The Cloud controller manager is a daemon that embeds the cloud specific control loops shipped with Kubernetes.`,

Run: func(cmd *cobra.Command, args []string) {

c, err := s.Config()

if err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

// (4) Run里会运行相关controller loops:CloudNode Controller、PersistentVolumeLabel Controller、Service Controller、Route Controller

if err := app.Run(c.Complete()); err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

},

}

s.AddFlags(cmd.Flags())

pflag.CommandLine.SetNormalizeFunc(flag.WordSepNormalizeFunc)

pflag.CommandLine.AddGoFlagSet(goflag.CommandLine)

logs.InitLogs()

defer logs.FlushLogs()

if err := c.Execute(); err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

}五、部署使用Cloud Controller Manager实践

5.1 总体要求

- 云厂商提供给CCM的API需要有认证鉴权机制,防止恶意行为。

- 因为CCM运行在集群内,所以需要RBAC规则去跟kube-apiserver通讯

- CCM为了高可用,可开启选主功能

5.2 k8s相关组件的启动配置变化

将Cloud Provider改为CCM后,相关组件启动的配置需要修改。

5.2.1 kube-controller-manager启动配置变化

不指定cloud-provider。

5.2.2 kube-apiserver启动配置变化

(1)不指定cloud-provider

(2)admission-control中删去PersistentVolumeLabel,因为CCM将接手PersistentVolumeLabel

(3)admission-control中增加Initializers

(4)runtime-config中增加admissionregistration.k8s.io/v1alpha1

5.2.3 kubelet启动配置变化

指定cloud-provider=external,告诉kubelet,在它开始调度工作前,需要被CCM初始化。(node会被打上 Taints:node.cloudprovider.kubernetes.io/uninitialized=true:NoSchedule)

5.3 启动CCM举例

5.3.1 启用initializers并添加InitializerConifguration

CCM为了给PV打标签需要:

(1)启用initializers(https://kubernetes.io/docs/reference/access-authn-authz/extensible-admission-controllers/#enable-initializers-alpha-feature)

(2)添加InitializerConifguration:persistent-volume-label-initializer-config.yaml如下:

admin/cloud/pvl-initializer-config.yaml

kind: InitializerConfiguration

apiVersion: admissionregistration.k8s.io/v1alpha1

metadata:

name: pvlabel.kubernetes.io

initializers:

- name: pvlabel.kubernetes.io

rules:

- apiGroups:

- ""

apiVersions:

- "*"

resources:

- persistentvolumes5.3.2 创建CCM的RBAC

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: system:cloud-controller-manager

labels:

kubernetes.io/cluster-service: "true"

rules:

- apiGroups:

- ""

resources:

- nodes

verbs:

- '*'

- apiGroups:

- ""

resources:

- nodes/status

verbs:

- patch

- apiGroups:

- ""

resources:

- services

verbs:

- list

- watch

- patch

- apiGroups:

- ""

resources:

- services/status

verbs:

- update

- apiGroups:

- ""

resources:

- events

verbs:

- create

- patch

- update

# For leader election

- apiGroups:

- ""

resources:

- endpoints

verbs:

- create

- apiGroups:

- ""

resources:

- endpoints

resourceNames:

- "cloud-controller-manager"

verbs:

- get

- list

- watch

- update

- apiGroups:

- ""

resources:

- configmaps

verbs:

- create

- apiGroups:

- ""

resources:

- configmaps

resourceNames:

- "cloud-controller-manager"

verbs:

- get

- update

- apiGroups:

- ""

resources:

- serviceaccounts

verbs:

- create

- apiGroups:

- ""

resources:

- secrets

verbs:

- get

- list

# For the PVL

- apiGroups:

- ""

resources:

- persistentvolumes

verbs:

- list

- watch

- patch

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: xxx-cloud-controller-manager

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: system:cloud-controller-manager

subjects:

- kind: ServiceAccount

name: cloud-controller-manager

namespace: kube-system5.3.3 启动CCM

可以通过DaemonSet或者Deployment的方式启动CCM:

---

apiVersion: v1

kind: ServiceAccount

metadata:

name: cloud-controller-manager

namespace: kube-system

---

apiVersion: extensions/v1beta1

kind: DaemonSet

metadata:

name: xxx-cloud-controller-manager

namespace: kube-system

labels:

k8s-app: xxx-cloud-controller-manager

spec:

selector:

matchLabels:

k8s-app: xxx-cloud-controller-manager

updateStrategy:

type: RollingUpdate

template:

metadata:

labels:

k8s-app: xxx-cloud-controller-manager

spec:

hostNetwork: true

nodeSelector:

node-role.kubernetes.io/master: ""

tolerations:

- key: node.cloudprovider.kubernetes.io/uninitialized

value: "true"

effect: NoSchedule

- key: node-role.kubernetes.io/master

operator: Exists

effect: NoSchedule

serviceAccountName: cloud-controller-manager

containers:

- name: cloud-controller-manager

image: xxx-cloud-controller-manager:v1.0.0

args:

- --cloud-config=/path/to/cloud-config.yaml

- --cloud-provider=xxx

- -v=4

volumeMounts:

- name: cfg

mountPath: /etc/xxx

readOnly: true

- name: kubernetes

mountPath: /etc/kubernetes

readOnly: true

volumes:

- name: cfg

secret:

secretName: xxx-cloud-controller-manager

- name: kubernetes

hostPath:

path: /etc/kubernetes六、参考

智能推荐

如何配置DNS服务的正反向解析_dns反向解析-程序员宅基地

文章浏览阅读3k次,点赞3次,收藏13次。root@server ~]# vim /etc/named.rfc1912.zones #添加如下内容,也可直接更改模板。[root@server ~]# vim /etc/named.conf #打开主配置文件,将如下两处地方修改为。注意:ip地址必须反向书写,这里文件名需要和反向解析数据文件名相同。新建或者拷贝一份进行修改。nslookup命令。_dns反向解析

设置PWM占空比中TIM_SetCompare1,TIM_SetCompare2,TIM_SetCompare3,TIM_SetCompare4分别对应引脚和ADC通道对应引脚-程序员宅基地

文章浏览阅读2.5w次,点赞16次,收藏103次。这个函数TIM_SetCompare1,这个函数有四个,分别是TIM_SetCompare1,TIM_SetCompare2,TIM_SetCompare3,TIM_SetCompare4。位于CH1那一行的GPIO口使用TIM_SetCompare1这个函数,位于CH2那一行的GPIO口使用TIM_SetCompare2这个函数。使用stm32f103的除了tim6和tim7没有PWM..._tim_setcompare1

多线程_进程和线程,并发与并行,线程优先级,守护线程,实现线程的四种方式,线程周期;线程同步,线程中的锁,Lock类,死锁,生产者和消费者案例-程序员宅基地

文章浏览阅读950次,点赞33次,收藏19次。多线程_进程和线程,并发与并行,线程优先级,守护线程,实现线程的四种方式,线程周期;线程同步,线程中的锁,Lock类,死锁,生产者和消费者案例

在 Linux 系统的用户目录下安装 ifort 和 MKL 库并配置_在linux系统的用户目录下安装ifort和mkl库并配置-程序员宅基地

文章浏览阅读2.9k次。ifort 编译器的安装ifort 编译器可以在 intel 官网上下载。打开https://software.intel.com/content/www/us/en/develop/tools/oneapi/components/fortran-compiler.html#gs.7iqrsm点击网页中下方处的 Download, 选择 Intel Fortran Compiler Classic and Intel Fortran Compiler(Beta) 下方对应的版本。我选择的是 l_在linux系统的用户目录下安装ifort和mkl库并配置

使用ftl文件生成图片中图片展示无样式,不显示_ftl格式pdf的样式调整-程序员宅基地

文章浏览阅读689次,点赞7次,收藏8次。些项目时需要一个生成图片的方法,我在网上找到比较方便且适合我去设置一些样式的生成方式之一就是使用Freemarker,在对应位置上先写好一个html格式的ftl文件,在对应位置用${参数名}填写上。还记得当时为了解决图片大小设置不上,搜索了好久资料,不记得是在哪看到的需要在里面使用width与height直接设置,而我当时用style去设置,怎么都不对。找不到,自己测试链接,准备将所有含有中文的图片链接复制一份,在服务器上存储一份不带中文的文件。突然发现就算无中文,有的链接也是打不开的。_ftl格式pdf的样式调整

orin Ubuntu 20.04 配置 Realsense-ROS_opt/ros/noetic/lib/nodelet/nodelet: symbol lookup -程序员宅基地

文章浏览阅读1.5k次,点赞6次,收藏12次。拉取librealsense。_opt/ros/noetic/lib/nodelet/nodelet: symbol lookup error: /home/admin07/reals

随便推点

操作系统精选习题——第四章_系统抖动现象的发生由什么引起的-程序员宅基地

文章浏览阅读3.4k次,点赞3次,收藏29次。一.单选题二.填空题三.判断题一.单选题静态链接是在( )进行的。A、编译某段程序时B、装入某段程序时C、紧凑时D、装入程序之前Pentium处理器(32位)最大可寻址的虚拟存储器地址空间为( )。A、由内存的容量而定B、4GC、2GD、1G分页系统中,主存分配的单位是( )。A、字节B、物理块C、作业D、段在段页式存储管理中,当执行一段程序时,至少访问()次内存。A、1B、2C、3D、4在分段管理中,( )。A、以段为单位分配,每._系统抖动现象的发生由什么引起的

UG NX 12零件工程图基础_ug-nx工程图-程序员宅基地

文章浏览阅读2.4k次。在实际的工作生产中,零件的加工制造一般都需要二维工程图来辅助设计。UG NX 的工程图主要是为了满足二维出图需要。在绘制工程图时,需要先确定所绘制图形要表达的内容,然后根据需要并按照视图的选择原则,绘制工程图的主视图、其他视图以及某些特殊视图,最后标注图形的尺寸、技术说明等信息,即可完成工程图的绘制。1.视图选择原则工程图合理的表达方案要综合运用各种表达方法,清晰完整地表达出零件的结构形状,并便于看图。确定工程图表达方案的一般步骤如下:口分析零件结构形状由于零件的结构形状以及加工位置或工作位置的不._ug-nx工程图

智能制造数字化工厂智慧供应链大数据解决方案(PPT)-程序员宅基地

文章浏览阅读920次,点赞29次,收藏18次。原文《智能制造数字化工厂智慧供应链大数据解决方案》PPT格式主要从智能制造数字化工厂智慧供应链大数据解决方案框架图、销量预测+S&OP大数据解决方案、计划统筹大数据解决方案、订单履约大数据解决方案、库存周转大数据解决方案、采购及供应商管理大数据模块、智慧工厂大数据解决方案、设备管理大数据解决方案、质量管理大数据解决方案、仓储物流与网络优化大数据解决方案、供应链决策分析大数据解决方案进行建设。适用于售前项目汇报、项目规划、领导汇报。

网络编程socket accept函数的理解_当在函数 'main' 中调用 'open_socket_accept'时.line: 8. con-程序员宅基地

文章浏览阅读2w次,点赞38次,收藏102次。在服务器端,socket()返回的套接字用于监听(listen)和接受(accept)客户端的连接请求。这个套接字不能用于与客户端之间发送和接收数据。 accept()接受一个客户端的连接请求,并返回一个新的套接字。所谓“新的”就是说这个套接字与socket()返回的用于监听和接受客户端的连接请求的套接字不是同一个套接字。与本次接受的客户端的通信是通过在这个新的套接字上发送和接收数_当在函数 'main' 中调用 'open_socket_accept'时.line: 8. connection request fa

C#对象销毁_c# 销毁对象及其所有引用-程序员宅基地

文章浏览阅读4.3k次。对象销毁对象销毁的标准语法Close和Stop何时销毁对象销毁对象时清除字段对象销毁的标准语法Framework在销毁对象的逻辑方面遵循一套规则,这些规则并不限用于.NET Framework或C#语言;这些规则的目的是定义一套便于使用的协议。这些协议如下:一旦销毁,对象不可恢复。对象不能被再次激活,调用对象的方法或者属性抛出ObjectDisposedException异常重复地调用对象的Disposal方法会导致错误如果一个可销毁对象x 包含或包装或处理另外一个可销毁对象y,那么x的Disp_c# 销毁对象及其所有引用

笔记-中项/高项学习期间的错题笔记1_大型设备可靠性测试可否拆解为几个部分进行测试-程序员宅基地

文章浏览阅读1.1w次。这是记录,在中项、高项过程中的错题笔记;https://www.zenwu.site/post/2b6d.html1. 信息系统的规划工具在制订计划时,可以利用PERT图和甘特图;访谈时,可以应用各种调查表和调查提纲;在确定各部门、各层管理人员的需求,梳理流程时,可以采用会谈和正式会议的方法。为把企业组织结构与企业过程联系起来,说明每个过程与组织的联系,指出过程决策人,可以采用建立过程/组织(Process/Organization,P/O)矩阵的方法。例如,一个简单的P/O矩阵示例,其中._大型设备可靠性测试可否拆解为几个部分进行测试