yum安装K8S,k8s加dockerfile部署运行nginx+tomcat+httpd实现动静分离,容器重建后自动映射端口_env "path=$path-程序员宅基地

技术标签: kubernetes 容器 nginx K8S集群,容器技术 kubelet docker

1、使用kubeadm安装k8s

K8S的组件:K8S组件文档

- kube-apiserver:提供对K8S资源操作的唯一入口,让K8S的认证,授权,访问控制,API注册等功能得以实现

- etcd:为K8S提供分布式集群,对数据进行备份等功能

- kube-scheduler:K8S的pod调度器,主要用于master将node节点的资源情况收集并判断新的pod容器存放到资源空闲node节点上。

- kube-controller-manager:K8S的管理中心,主要负责维护K8S集群的健康状态,自动扩展,故障处理,账户认证,namespace、endpoint等资源的控制

- kube-proxy:是K8S的service一部分,主要是用于对K8S的master和node之间、pod和pod容器之间的网路访问控制等

- kubelet:主要用于维护pod容器的生命周期,接收master对node节点的指令等

- kube-flannel:主要管理K8S集群中service、node、pod的网络部署

- coredns:主要用于pod和pod之间进行域名解析,pod和外网域名解析

安装K8S集群主要使用到kubeadm,kubelet,docker工具进行安装

kubeadm:kubeadm工具介绍

集群部署文档:K8S集群部署文档

准备环境:

| 工具 | 版本 |

|---|---|

| 系统 | centos 7.7 |

| kubeadm | 1.17.2 |

| kubelet | 1.17.2 |

| docker | 19.03.5 |

| master | 192.168.116.130 |

| node | 192.168.116.132 |

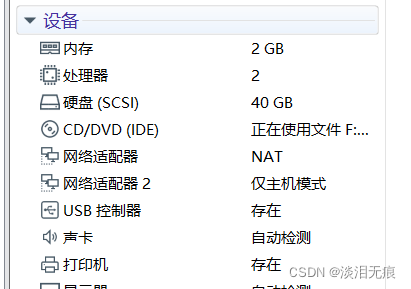

master节点和node节点配置:

CPU要双核以上

设备的内核要升级到4.0版本以上

内核升级文档:内核

1.1 设备都初始化yum源:

cd /etc/yum.repos.d/

yum install -y wget

wget http://mirrors.aliyun.com/repo/Centos-7.repo

wget http://mirrors.aliyun.com/repo/epel-7.repo

mv CentOS-Base.repo CentOS-Base.repo.bak

yum clean all

yum makecache

systemctl disable firewalld

systemctl stop firewalld

sed -i 's/SELINUX=enforcing$/SELINUX=disabled/g' /etc/selinux/config

setenforce 0

设置hosts

vi /etc/hosts

192.168.116.130 k8s-master

192.168.116.132 k8s-node1

修改内核参数,加载br_netfilter模块

设置开机启动模块

cat <<EOF | sudo tee /etc/modules-load.d/k8s.conf

br_netfilter

EOF

modprobe br_netfilter 手动临时加载模块

lsmod |grep br_netfilter 查看模块是否加载成功

vi /etc/sysctl.d/k8s.conf 修改内核参数

添加

net.ipv4.ip_forward=1

net.bridge.bridge-nf-call-ip6tables =1

net.bridge.bridge-nf-call-iptables = 1

sysctl -p /etc/sysctl.d/k8s.conf 启动修改

sysctl -a |grep bridge 确认修改成功

1.2 设备都安装docker

wget -O /etc/yum.repos.d/docker-ce.repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum list docker-ce --showduplicates | sort -r 查看可以安装的docker全部版本

yum install docker-ce.x86_64 3:19.03.5-3.el7 -y 指定版本安装

vi /usr/lib/systemd/system/docker.service 修改文件启动模式为systemd

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock --exec-opt native.cgroupdriver=systemd

systemctl daemon-reload

systemctl start docker

systemctl enable docker

1.3 设备都安装K8S源

K8S不需要swap分区,关闭swap

swapoff -a 关闭swap分区

vi /etc/fstab 在开机挂载中取消挂载,对分区输入#注释

#/dev/mapper/centos-swap swap swap defaults 0 0

mount -a

设置k8s源

cat <<EOF | sudo tee /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

EOF

yum list kubeadm --showduplicates | sort -r 查看K8S版本

yum install kubeadm-1.17.2-0 kubectl-1.17.2-0 kubelet-1.17.2-0 -y 安装指定版本

systemctl enable kubelet master和node都要设置这个开机自启,要不然K8S不会开机自启

1.4 master开始初始化

hostnamectl set-hostname k8s-master

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.17.2

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.17.2

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.17.2

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.17.2

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.4.3-0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.6.5

开始初始化

kubeadm init --apiserver-advertise-address=192.168.116.130 --kubernetes-version=v1.17.2 --pod-network-cidr=10.100.0.0/16 --service-cidr=10.200.0.0/16 --service-dns-domain=k8s-master --image-repository=registry.cn-hangzhou.aliyuncs.com/google_containers --ignore-preflight-errors=swap

--apiserver-advertise-address=192.168.116.130 指定本机IP

--kubernetes-version=v1.17.2 指定安装的K8S的版本

--pod-network-cidr=10.100.0.0/16 设置pod的网络

--service-cidr=10.200.0.0/16 设置service网络,也就是master和node之间的网络

--service-dns-domain=k8s-master 设置本机域名

repository=registry.cn-hangzhou.aliyuncs.com/google_containers 设置镜像来源

--ignore-preflight-errors=swap 忽略swap告警

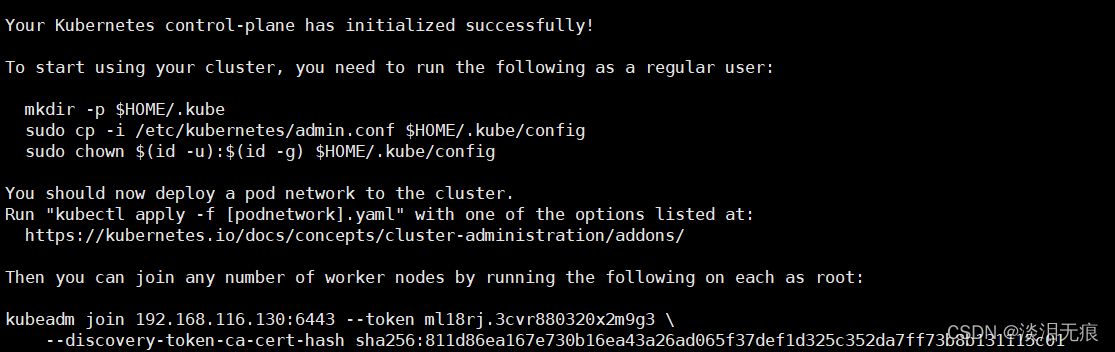

出现下面这个图表示安装成功,按照提示配置k8s

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

注意:这个需要手动保存好,到时候添加node需要用到

kubeadm join 192.168.116.130:6443 --token ml18rj.3cvr880320x2m9g3 \

--discovery-token-ca-cert-hash sha256:811d86ea167e730b16ea43a26ad065f37def1d325c352da7ff73b8b131115c01

1.5 node节点配置加入集群

按照上面安装好docker和k8s,源等

hostnamectl set-hostname k8s-node1

还是要下载镜像

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.17.2

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.17.2

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.17.2

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.17.2

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.1

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.4.3-0

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.6.5

将master安装后出现的这句话运行即可加入

kubeadm join 192.168.116.130:6443 --token ml18rj.3cvr880320x2m9g3 \

--discovery-token-ca-cert-hash sha256:811d86ea167e730b16ea43a26ad065f37def1d325c352da7ff73b8b131115c01

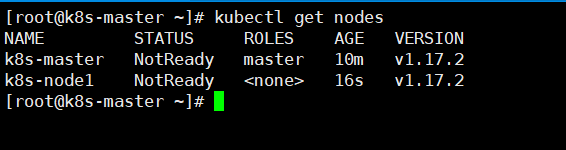

master查看node是否加入成功

kubectl get nodes

1.6 master安装kube-flannel网络

默认K8S集群会没有网络,需要自己运行网络容器

下载这个文件

wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

vi kube-flannel.yml 然后修改pod网段

"Network": "10.100.0.0/16", #修改这个为上面定义的--pod-network-cidr=10.100.0.0/16

kubectl apply -f kube-flannel.yml 然后运行容器

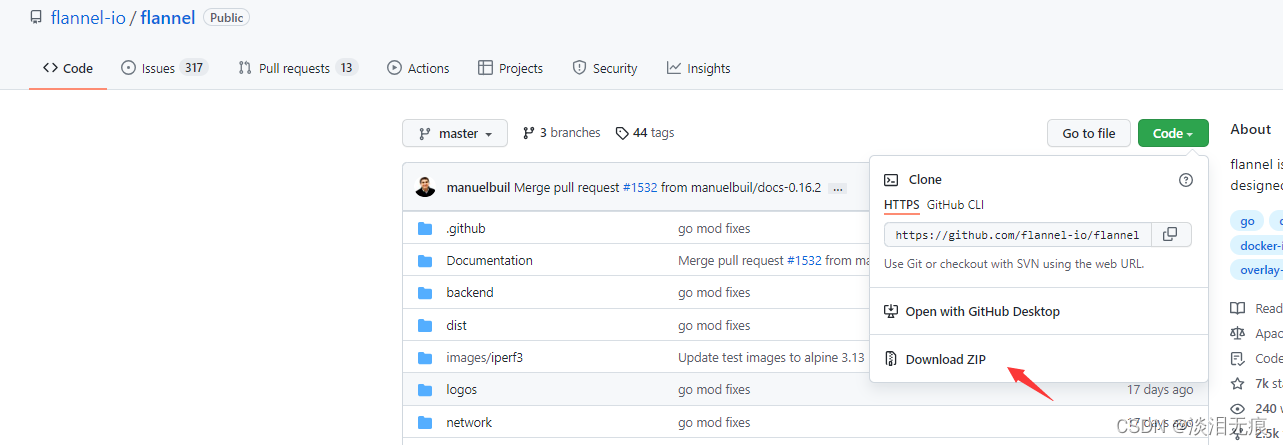

上面如果不能下载,只能自己去网站下载:flannel

yum install -y unzip

将下载好的flannel-master.zip 放到k8s-master目录下

unzip flannel-master.zip

cd flannel-master/Documentation/

vi kube-flannel.yml 修改这里

"Network": "10.100.0.0/16", #修改这个为上面定义的--pod-network-cidr=10.100.0.0/16

kubectl apply -f kube-flannel.yml

k8s-master创建容器测试能否通外网

kubectl run net-test --image=alpine --replicas=2 sleep 360000 创建2个容器

kubectl get pod -A 查看容器id

kubectl exec -it net-test-6c94768685-hqx2k sh 指定id连接容器

ip a 查看容器获取到的ip是10.100.0.0/16网段

ping 114.114.114.114 测试外网通信

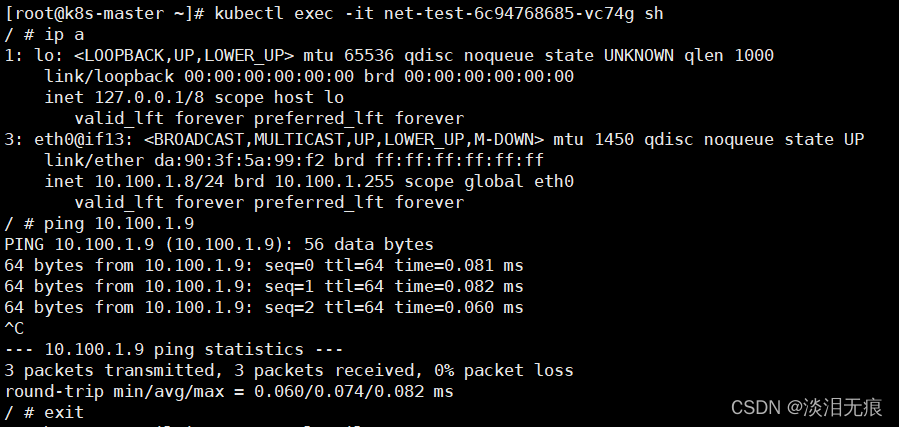

master 测试容器之间是否能通信

kubectl exec -it net-test-6c94768685-vc74g sh 连接另外一台容器

ping 10.100.1.9 ping另外一台容器IP

2、k8s加dockerfile部署运行nginx+tomcat+httpd实现动静分离,容器重建后自动映射端口

按照上面搭建K8S集群

拓扑图:

2.1 master配置nginx的dockerfile镜像

mkdir /dockerfile/nginx -p

cd /dockerfile/nginx/

下载nginx源码包

wget http://nginx.org/download/nginx-1.18.0.tar.gz

设置alpine的源

vi repositories

https://mirrors.aliyun.com/alpine/v3.14/main

https://mirrors.aliyun.com/alpine/v3.14/community

vi nginx.conf 配置nginx的配置文件

user nginx;

daemon off;

worker_processes auto;

error_log /app/nginx/logs/nginx-error.log;

pid /app/nginx/run/nginx.pid;

events {

worker_connections 10240;

}

http {

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /app/nginx/logs/nginx-access.log main;

sendfile on;

tcp_nopush on;

tcp_nodelay on;

keepalive_timeout 65;

types_hash_max_size 4096;

server {

listen 80;

server_name k8s-nginx;

location / {

proxy_pass http://k8s-httpd-1-service:80;

index index.html index.htm;

}

location ~* \.jsp$ {

proxy_pass http://k8s-tomcat-1-service:8080;

}

}

}

vi nginx-dockerfile

FROM alpine

COPY repositories /etc/apk/

RUN addgroup -S nginx && adduser -s /sbin/nologin -S -D -G nginx nginx

#nginx

RUN mkdir /app

RUN apk add psmisc net-tools wget gcc g++ make pcre-dev zlib-dev

ADD nginx-1.18.0.tar.gz /app/

RUN cd /app/nginx-1.18.0/ && ./configure --prefix=/app/nginx --user=nginx\

--user=nginx\

--group=nginx\

--with-http_ssl_module\

--with-http_v2_module\

--with-http_realip_module\

--with-http_stub_status_module\

--with-http_gzip_static_module\

--with-pcre\

--with-stream\

--with-stream_ssl_module\

--with-stream_realip_module && make && make install

RUN mkdir /app/nginx/run

ENV PATH=$PATH:/app/nginx/sbin

RUN chown nginx.nginx -R /app/

COPY nginx.conf /app/nginx/conf/

EXPOSE 80

CMD ["nginx"]

制作nginx镜像

docker build -t test/nginx:v1.0 -f nginx-dockerfile .

2.2 master配置tomcat的dockefile镜像

mkdir /dockerfile/tomcat

cd /dockerfile/tomcat/

下载jdk包

wget https://repo.huaweicloud.com/java/jdk/8u191-b12/jdk-8u191-linux-x64.tar.gz

下载tomcat包

wget https://mirrors.bfsu.edu.cn/apache/tomcat/tomcat-8/v8.5.77/bin/apache-tomcat-8.5.77.tar.gz --no-check-certificate

设置jdk路径

vi tomcat.conf

JAVA_HOME=/usr/local/jdk

设置tomcat主页

vi index.jsp

<%@ page language="java" contentType="text/html; charset=UTF-8"

pageEncoding="UTF-8"%>

<!DOCTYPE html>

<html>

<head>

<meta charset="utf-8">

<title>tomcat-test</title>

</head>

<body>

<h1>tomcat-test</h1>

<%

out.println("test");

%>

<br>

<%=request.getRequestURL()%>

</body>

</html>

配置镜像dockerfile

vi tomcat-dockerfile

FROM centos:7.7.1908

RUN yum install -y wget

#jdk

COPY jdk-8u191-linux-x64.tar.gz /

ADD jdk-8u191-linux-x64.tar.gz /usr/local/

RUN ln -s /usr/local/jdk1.8.0_191 /usr/local/jdk

ENV JAVA_HOME=/usr/local/jdk

ENV PATH=$PATH:$JAVA_HOME/bin

ENV JRE_HOME=$JAVA_HOME/jre

ENV CLASSPATH=$JAVA_HOME/lib/:$JRE_HOME/lib

#tomcat

COPY apache-tomcat-8.5.77.tar.gz /

ADD apache-tomcat-8.5.77.tar.gz /usr/local/

RUN ln -s /usr/local/apache-tomcat-8.5.77 /usr/local/tomcat

ENV PATH=$PATH:/usr/local/tomcat/bin

COPY tomcat.conf /usr/local/tomcat/conf/

COPY index.jsp /usr/local/tomcat/webapps/ROOT/

EXPOSE 8080

CMD ["/usr/local/tomcat/bin/catalina.sh","run" ]

制作tomcat镜像

docker build -t test/tomcat:v1.0 -f tomcat-dockerfile .

前台运行测试镜像能否使用

docker run --rm -it -p 8080:8080 test/tomcat:v1.0

curl 192.168.116.130:8080

2.3 master配置httpd的dockefile镜像

mkdir /dockerfile/httpd

cd /dockerfile/httpd/

设置alpine的源

vi repositories

https://mirrors.aliyun.com/alpine/v3.14/main

https://mirrors.aliyun.com/alpine/v3.14/community

下载源码包

wget https://dlcdn.apache.org/apr/apr-1.7.0.tar.gz --no-check-certificate

wget https://dlcdn.apache.org/apr/apr-util-1.6.1.tar.gz --no-check-certificate

wget http://archive.apache.org/dist/httpd/httpd-2.4.46.tar.gz --no-check-certificate

vi httpd-dockerfile

FROM alpine

COPY repositories /etc/apk/

RUN apk add wget make curl net-tools psmisc gcc g++ expat-dev pcre-dev

RUN mkdir /app

ADD apr-1.7.0.tar.gz /app

ADD apr-util-1.6.1.tar.gz /app

ADD httpd-2.4.46.tar.gz /app

RUN cd /app/apr-1.7.0/ && sed -ri 's@\$RM "\$cfgfile"@\# \$RM "\$cfgfile"@g' configure && ./configure --prefix=/app/apr && make && make install

RUN cd /app/apr-util-1.6.1/ && ./configure --prefix=/app/apr-util --with-apr=/app/apr/ && make && make install

RUN cd /app/httpd-2.4.46/ && ./configure --prefix=/app/httpd --with-apr=/app/apr/ --with-apr-util=/app/apr-util/ && make && make install

RUN echo "ServerName k8s-httpd-1-service" >>/app/httpd/conf/httpd.conf

ENV PATH=$PATH:/app/httpd/bin

EXPOSE 80

ENTRYPOINT [ "httpd" ]

CMD ["-D", "FOREGROUND"]

docker build -t test/httpd:v1.0 -f httpd-dockerfile . 制作镜像

测试镜像是否能前台运行

docker run --rm -it -p 80:80 test/httpd:v1.0

curl 192.168.116.130

2.4 master制作K8S的容器文件

将k8s-master制作好的镜像保存传送到node节点,要不然容器运行不了

docker save test/nginx:v1.0 -o /root/k8s-nginx.tar

docker save test/tomcat:v1.0 -o /root/k8s-tomcat.tar

docker save test/httpd:v1.0 -o /root/k8s-httpd.tar

scp /root/k8s-nginx.tar 192.168.116.132:/root/

scp /root/k8s-tomcat.tar 192.168.116.132:/root/

scp /root/k8s-httpd.tar 192.168.116.132:/root/

node节点导入镜像到docker

注意:因为是用本地镜像,所以有多个node的话,每个node都要手动导入镜像

docker load -i k8s-nginx.tar

docker load -i k8s-tomcat.tar

docker load -i k8s-httpd.tar

在k8s-master制作tomcat.yml容器文件

vi tomcat.yml

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: k8s-tomcat-1

name: k8s-tomcat-1-deployment

namespace: default

spec:

replicas: 1

selector:

matchLabels:

app: k8s-tomcat-1

template:

metadata:

labels:

app: k8s-tomcat-1

spec:

containers:

- name: k8s-tomcat-1-container

image: test/tomcat:v1.0

imagePullPolicy: Never

ports:

- containerPort: 8080

protocol: TCP

name: k8s-tomcat-1

---

apiVersion: v1

kind: Service

metadata:

labels:

app: k8s-tomcat-1

name: k8s-tomcat-1-service

namespace: default

spec:

ports:

- name: k8s-tomcat-1

port: 8080

selector:

app: k8s-tomcat-1

在k8s-master制作httpd.yml容器文件

vi httpd.yml

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: k8s-httpd-1

name: k8s-httpd-1-deployment

namespace: default

spec:

replicas: 1

selector:

matchLabels:

app: k8s-httpd-1

template:

metadata:

labels:

app: k8s-httpd-1

spec:

containers:

- name: k8s-httpd-1-container

image: test/httpd:v1.0

imagePullPolicy: Never

ports:

- containerPort: 80

protocol: TCP

name: k8s-httpd-1

---

apiVersion: v1

kind: Service

metadata:

labels:

app: k8s-httpd-1

name: k8s-httpd-1-service

namespace: default

spec:

ports:

- name: k8s-httpd-1

port: 80

selector:

app: k8s-httpd-1

在k8s-master制作nginx.yml容器文件

vi nginx.yml

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: nginx

name: nginx-deployment

namespace: default

spec:

replicas: 1

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx-container

image: test/nginx:v1.0

imagePullPolicy: Never

ports:

- containerPort: 80

protocol: TCP

name: httpd

---

apiVersion: v1

kind: Service

metadata:

labels:

app: nginx

name: k8s-nginx-service

namespace: default

spec:

type: NodePort

ports:

- name: httpd

port: 80

protocol: TCP

targetPort: 80

nodePort: 30080

selector:

app: nginx

sessionAffinity: ClientIP

sessionAffinityConfig:

clientIP:

timeoutSeconds: 10800

2.5 在k8s-master运行容器,测试动静分离

kubectl run net-test --image=alpine --replicas=1 sleep 360000 创建测试容器

kubectl apply -f httpd.yml

kubectl apply -f tomcat.yml

kubectl apply -f nginx.yml

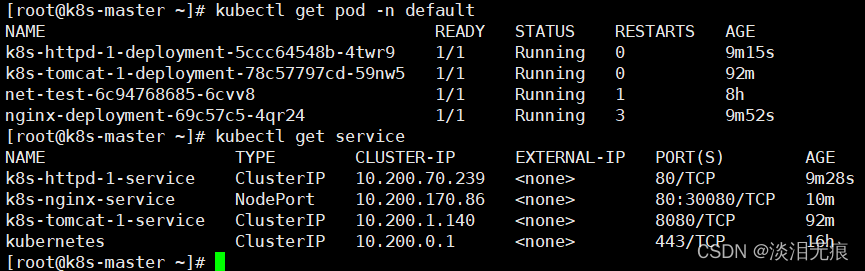

确认容器和service都正常运行

kubectl get pod -n default

kubectl get service

设置测试容器的源和安装工具

vi /etc/apk/repositories 把文件改为下面这些源

https://mirrors.aliyun.com/alpine/v3.14/main

https://mirrors.aliyun.com/alpine/v3.14/community

apk add curl

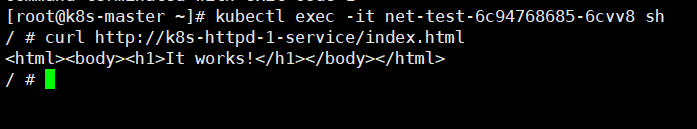

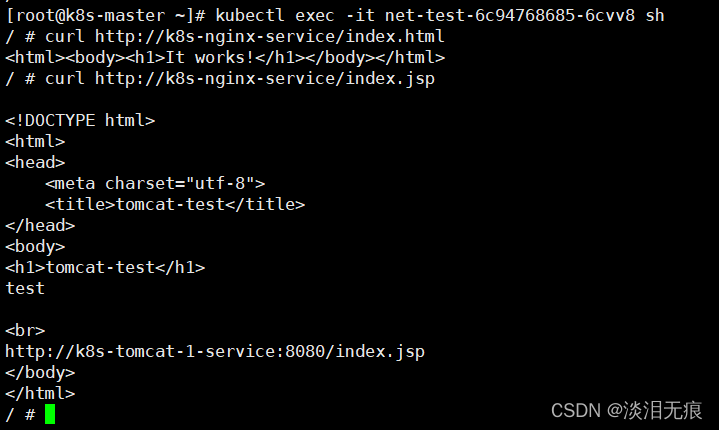

在测试容器测试httpd容器是否能正常工作

kubectl exec -it net-test-6c94768685-6cvv8 sh

curl http://k8s-httpd-1-service/index.html

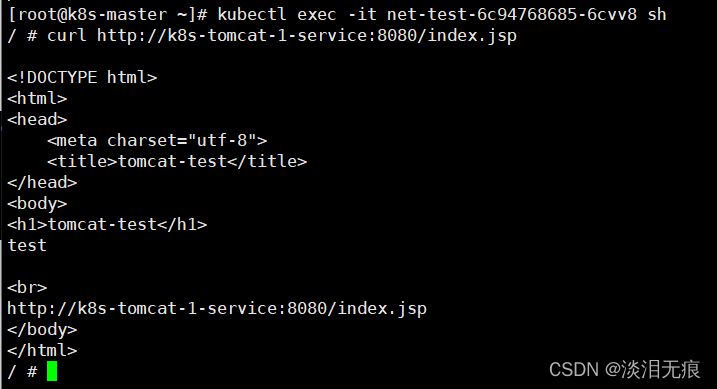

在测试容器测试tomcat容器是否能正常工作

kubectl exec -it net-test-6c94768685-6cvv8 sh

curl http://k8s-tomcat-1-service:8080/index.jsp

在测试容器测试nginx容器是否能正常工作

kubectl exec -it net-test-6c94768685-6cvv8 sh

可以看到访问nginx容器的静态文件被调用到了httpd容器

curl http://k8s-nginx-service/index.html

可以看到访问nginx容器的动态文件被调用到了tomcat容器

curl http://k8s-nginx-service/index.jsp

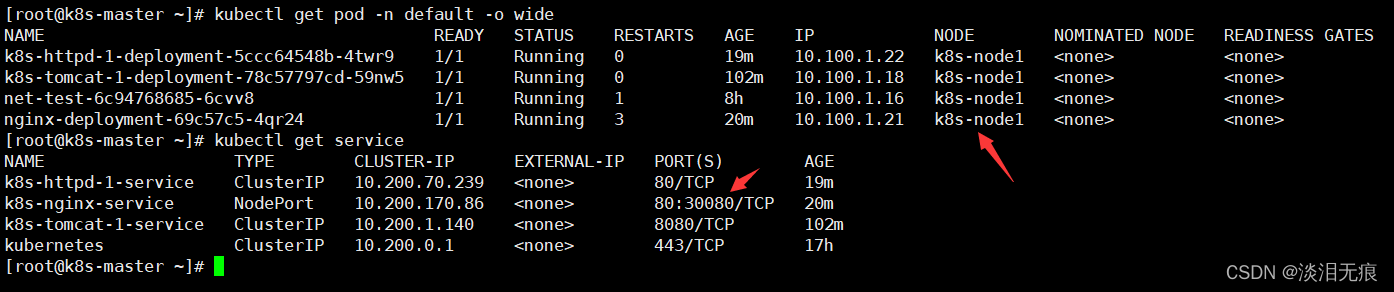

2.6 查看nginx容器的外网映射关系

查看容器被安装在哪个node节点上

kubectl get pod -n default -o wide

查看nginx对应的外网映射端口

kubectl get service

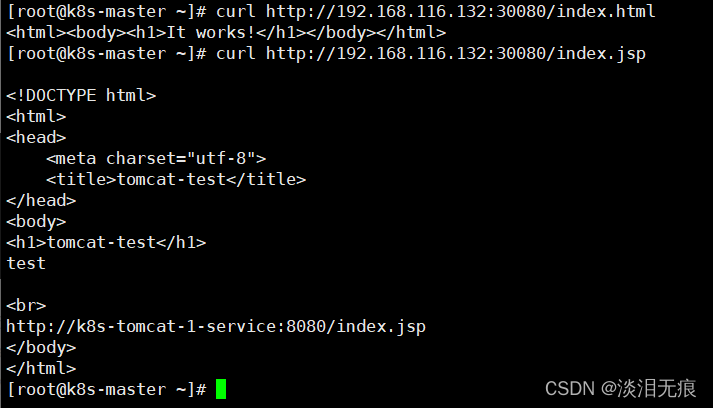

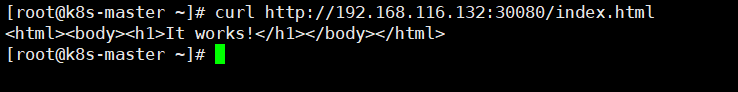

测试nginx容器映射访问

curl http://192.168.116.132:30080/index.html

curl http://192.168.116.132:30080/index.jsp

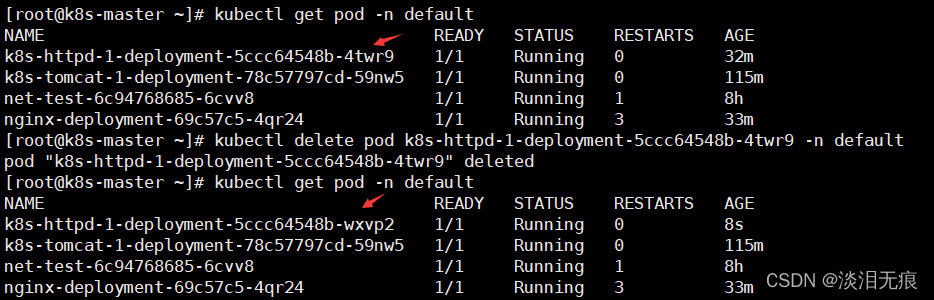

2.7 重建容器,测试容器重建后映射端口

kubectl get pod -n default 查看老的容器

kubectl delete pod k8s-httpd-1-deployment-5ccc64548b-4twr9 -n default 指定pod删除容器

kubectl get pod -n default 可以看到新的容器自动生成

因为nginx容器使用了service名称作反向代理,所以容器即使重建导致IP变动,nginx容器的反向代理不会变化

curl http://192.168.116.132:30080/index.html

智能推荐

获取大于等于一个整数的最小2次幂算法(HashMap#tableSizeFor)_整数 最小的2的几次方-程序员宅基地

文章浏览阅读2w次,点赞51次,收藏33次。一、需求给定一个整数,返回大于等于该整数的最小2次幂(2的乘方)。例: 输入 输出 -1 1 1 1 3 4 9 16 15 16二、分析当遇到这个需求的时候,我们可能会很容易想到一个"笨"办法:..._整数 最小的2的几次方

Linux 中 ss 命令的使用实例_ss@,,x,, 0-程序员宅基地

文章浏览阅读865次。选项,以防止命令将 IP 地址解析为主机名。如果只想在命令的输出中显示 unix套接字 连接,可以使用。不带任何选项,用来显示已建立连接的所有套接字的列表。如果只想在命令的输出中显示 tcp 连接,可以使用。如果只想在命令的输出中显示 udp 连接,可以使用。如果不想将ip地址解析为主机名称,可以使用。如果要取消命令输出中的标题行,可以使用。如果只想显示被侦听的套接字,可以使用。如果只想显示ipv4侦听的,可以使用。如果只想显示ipv6侦听的,可以使用。_ss@,,x,, 0

conda activate qiuqiu出现不存在activate_commandnotfounderror: 'activate-程序员宅基地

文章浏览阅读568次。CommandNotFoundError: 'activate'_commandnotfounderror: 'activate

Kafka 实战 - Windows10安装Kafka_win10安装部署kafka-程序员宅基地

文章浏览阅读426次,点赞10次,收藏19次。完成以上步骤后,您已在 Windows 10 上成功安装并验证了 Apache Kafka。在生产环境中,通常会将 Kafka 与外部 ZooKeeper 集群配合使用,并考虑配置安全、监控、持久化存储等高级特性。在生产者窗口中输入一些文本消息,然后按 Enter 发送。ZooKeeper 会在新窗口中运行。在另一个命令提示符窗口中,同样切换到 Kafka 的。Kafka 服务器将在新窗口中运行。在新的命令提示符窗口中,切换到 Kafka 的。,应显示已安装的 Java 版本信息。_win10安装部署kafka

【愚公系列】2023年12月 WEBGL专题-缓冲区对象_js 缓冲数据 new float32array-程序员宅基地

文章浏览阅读1.4w次。缓冲区对象(Buffer Object)是在OpenGL中用于存储和管理数据的一种机制。缓冲区对象可以存储各种类型的数据,例如顶点、纹理坐标、颜色等。在渲染过程中,缓冲区对象中存储的数据可以被复制到渲染管线的不同阶段中,例如顶点着色器、几何着色器和片段着色器等,以完成渲染操作。相比传统的CPU访问内存,缓冲区对象的数据存储和管理更加高效,能够提高OpenGL应用的性能表现。_js 缓冲数据 new float32array

四、数学建模之图与网络模型_图论与网络优化数学建模-程序员宅基地

文章浏览阅读912次。(1)图(Graph):图是数学和计算机科学中的一个抽象概念,它由一组节点(顶点)和连接这些节点的边组成。图可以是有向的(有方向的,边有箭头表示方向)或无向的(没有方向的,边没有箭头表示方向)。图用于表示各种关系,如社交网络、电路、地图、组织结构等。(2)网络(Network):网络是一个更广泛的概念,可以包括各种不同类型的连接元素,不仅仅是图中的节点和边。网络可以包括节点、边、连接线、路由器、服务器、通信协议等多种组成部分。网络的概念在各个领域都有应用,包括计算机网络、社交网络、电力网络、交通网络等。_图论与网络优化数学建模

随便推点

android 加载布局状态封装_adnroid加载数据转圈封装全屏转圈封装-程序员宅基地

文章浏览阅读1.5k次。我们经常会碰见 正在加载中,加载出错, “暂无商品”等一系列的相似的布局,因为我们有很多请求网络数据的页面,我们不可能每一个页面都写几个“正在加载中”等布局吧,这时候将这些状态的布局封装在一起就很有必要了。我们可以将这些封装为一个自定布局,然后每次操作该自定义类的方法就行了。 首先一般来说,从服务器拉去数据之前都是“正在加载”页面, 加载成功之后“正在加载”页面消失,展示数据;如果加载失败,就展示_adnroid加载数据转圈封装全屏转圈封装

阿里云服务器(Alibaba Cloud Linux 3)安装部署Mysql8-程序员宅基地

文章浏览阅读1.6k次,点赞23次,收藏29次。PS: 如果执行sudo grep 'temporary password' /var/log/mysqld.log 后没有报错,也没有任何结果显示,说明默认密码为空,可以直接进行下一步(后面设置密码时直接填写新密码就行)。3.(可选)当操作系统为Alibaba Cloud Linux 3时,执行如下命令,安装MySQL所需的库文件。下面示例中,将创建新的MySQL账号,用于远程访问MySQL。2.依次运行以下命令,创建远程登录MySQL的账号,并允许远程主机使用该账号访问MySQL。_alibaba cloud linux 3

excel离散度图表怎么算_excel离散数据表格-Excel 离散程度分析图表如何做-程序员宅基地

文章浏览阅读7.8k次。EXCEL中数据如何做离散性分析纠错。离散不是均值抄AVEDEV……=AVEDEV(A1:A100)算出来的是A1:A100的平均数。离散是指各项目间指标袭的离散均值(各数值的波动情况),数值较低表明项目间各指标波动幅百度小,数值高表明波动幅度较大。可以用excel中的离散公式为STDEV.P(即各指标平均离散)算出最终度离散度。excel表格函数求一组离散型数据,例如,几组C25的...用exc..._excel数据分析离散

学生时期学习资源同步-JavaSE理论知识-程序员宅基地

文章浏览阅读406次,点赞7次,收藏8次。i < 5){ //第3行。int count;System.out.println ("危险!System.out.println(”真”);System.out.println(”假”);System.out.print(“姓名:”);System.out.println("无匹配");System.out.println ("安全");

linux 性能测试磁盘状态监测:iostat监控学习,包含/proc/diskstats、/proc/stat简单了解-程序员宅基地

文章浏览阅读3.6k次。背景测试到性能、压力时,经常需要查看磁盘、网络、内存、cpu的性能值这里简单介绍下各个指标的含义一般磁盘比较关注的就是磁盘的iops,读写速度以及%util(看磁盘是否忙碌)CPU一般比较关注,idle 空闲,有时候也查看wait (如果wait特别大往往是io这边已经达到了瓶颈)iostatiostat uses the files below to create ..._/proc/diskstat

glReadPixels读取保存图片全黑_glreadpixels 全黑-程序员宅基地

文章浏览阅读2.4k次。问题:在Android上使用 glReadPixel 读取当前渲染数据,在若干机型(华为P9以及魅族某魅蓝手机)上读取数据失败,glGetError()没有抓到错误,但是获取到的数据有误,如果将获取到的数据保存成为图片,得到的图片为黑色。解决方法:glReadPixels实际上是从缓冲区中读取数据,如果使用了双缓冲区,则默认是从正在显示的缓冲(即前缓冲)中读取,而绘制工作是默认绘制到后缓..._glreadpixels 全黑