”中文分词器“ 的搜索结果

solr7.3.1种需要的中文IK分词器,其中包括IK分词的jar和配置文件还有mmseg4j

aAnsj中文分词 这是一个ictclas的java实现.基本上重写了所有的数据结构和算法.词典是用的开源版的ictclas所提供的.并且进行了部分的人工优化 内存中中文分词每秒钟

列举了当前常用的中文分词器及其地址链接,不用再进行网络查找,直接可以进行使用。

苹果从很早就开始支持中文分词了,而且我们几乎人人每天都会用到,回想一下,在使用手机时,长按一段文字,往往会选中按住位置的一个词语,这里就是一个分词的绝佳用例,而iOS自带的分词效果非常棒,大家可以自己...

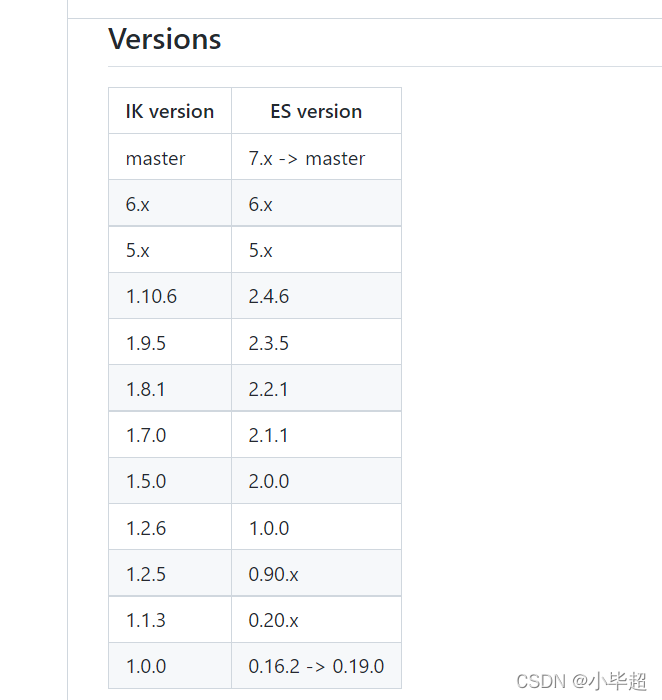

默认情况下,ElasticSearch是不带中文分词器的,所以我们需要单独下载安装。首先我们要确认一下中文分词器IK的版本与ElasticSearch的对应关系。IK versionES versionmaster2.2.0 -> master1.8.02.2.01.7.02.1....

Java有11大开源中文分词器,分别是word分词器,Ansj分词器,Stanford分词器,FudanNLP分词器,Jieba分词器,Jcseg分词器,MMSeg4j分词器,IKAnalyzer分词器,Paoding分词器,smartcn分词器,HanLP分词器。...

中文分词作为自然语言处理的分支,也是中文人机自然语言交互的基础模块,与之英文不同的是,中文分词没有词的界限,因此在进行中文自然语言处理时,通常需要先进行分词,分词效果将直接影响词性,句法树等模块的效果...

上一篇博文记录了elasticsearch插件安装和管理, 在地大物博的祖国使用es,不得不考虑中文分词器,es内置的分词器对中文分词的支持用惨不忍睹来形容不为过,看这篇博文之前,建议先看一下博文elasticsearch...

IK中文分词器的安装 ES默认是没有IK中文分词器的,我们要将IK中文分词器作为一个插件安装到ES中,安装的步骤也很简单: 从GitHub上下载适合自己ES版本的IK中文分词器,地址如下:...

本文主要介绍了 ik 分词器在es中的一些配置以及原理,包括 下载安装、如何设置es使用ik分词器、ik分词器与默认分词器的差异、ik分词自定义设置以及热更等等。 一、安装下载 ik分词器:...

该分词器支持solr7.x

我们可以在solr Analysis中进行分词,采用默认的英文分词器,可以看到中文被切分成了单个汉字,而按照自然语言来讲,我们更希望将其分词为俺中国man,这样本身也符合语言习惯,同时不用单个字分词,也节约了存储空间...

常用的中文分词器 Smart Chinese Analysis:官方提供的中文分词器,不好用。 IK Analyzer:免费开源的java分词器,目前比较流行的中文分词器之一,简单、稳定,想要特别好的效果,需要自行维护词库,支持自定义词典...

中文作为全球最优美、最复杂的语言,目前中文分词器较多,ik-analyzer、结巴中文分词、THULAC、NLPIR和阿里的aliws都是非常优秀的,我们以ik-analyzer作为讲解的重点,其它分词器可以举一反三。 概要 本篇主要介绍...

IK中分分词器,在全文检索中非常有用,尤其对于中文文档的全文检索。本压缩包打包文件可以满足使用solr建立全文检索的配置需求。

Jcseg中文分词器 v2.6.3.zip

Friso中文分词器 v1.6.4.zip

兼容solr-cloud,动态词典配置文件及动态词典可交由zookeeper进行管理,lucene版本为7.6.0

IK中文分词器资源包

标签: 分词器

IK中文分词器资源包

elasticsearch提供了几个内置的分词器:standard analyzer(标准分词器)、simple analyzer(简单分词器)、whitespace analyzer(空格分词器)、language analyzer(语言分词器),而如果我们不指定分词器类型的话,...

基于HMM的中文分词器 基于Scala实现。 开发人员 WeChat: wgybzb QQ: 1010437118 E-mail:

ik-analyzer-8.3.0,强大的中文分词器,已经在项目中成功使用

详细讲解IK分词器原理

IKAnalyzer中文分词器

标签: 中文分词器

IKAnalyzer中文分词器

IK中文分词器 支持solr5.0 以上版本。

一、几个项目github star对比在网上可以看到很多中文分词器的文章,但是都没说明白到底选择什么。当然一般来说没有最好的只有最合适的,在分词能力、繁体支持等等都可考虑的方向。当然github上的star也可以作为开源...

推荐文章

- 机器学习之超参数优化 - 网格优化方法(随机网格搜索)_网格搜索参数优化-程序员宅基地

- Lumina网络进入SDN市场-程序员宅基地

- python引用传递的区别_php传值引用的区别-程序员宅基地

- 《TCP/IP详解 卷2》 笔记: 简介_tcpip详解卷二有必要看吗-程序员宅基地

- 饺子播放器Jzvd使用过程中遇到的问题汇总-程序员宅基地

- python- flask current_app详解,与 current_app._get_current_object()的区别以及异步发送邮件实例-程序员宅基地

- 堪比ps的mac修图软件 Pixelmator Pro 2.0.6中文版 支持Silicon M1_pixelmator堆栈-程序员宅基地

- 「USACO2015」 最大流 - 树上差分_usaco 差分-程序员宅基地

- Leetcode #315: 计算右侧小于当前元素的个数_找元素右边比他小的数字-程序员宅基地

- HTTP图解读书笔记(第六章 HTTP首部)响应首部字段_web响应的首部内容-程序员宅基地